Hvad er Convolutional Neural Net Architectureork Architecture?

Denne artikel blev offentliggjort som en del af Data Science Blogathon.

introduktion

arbejde på et projekt om billedgenkendelse eller Objektdetektion, men havde ikke det grundlæggende til at opbygge en arkitektur?,

I denne artikel, vi vil se, hvad der er convolutional neurale netværk arkitekturer, lige fra grundlæggende og vi vil tage en grundlæggende arkitektur som et case study på at anvende vores erfaringer, Den eneste forudsætning er at du skal blot vide, hvordan foldning virker, Men fortvivl ikke, det er meget simpelt !!

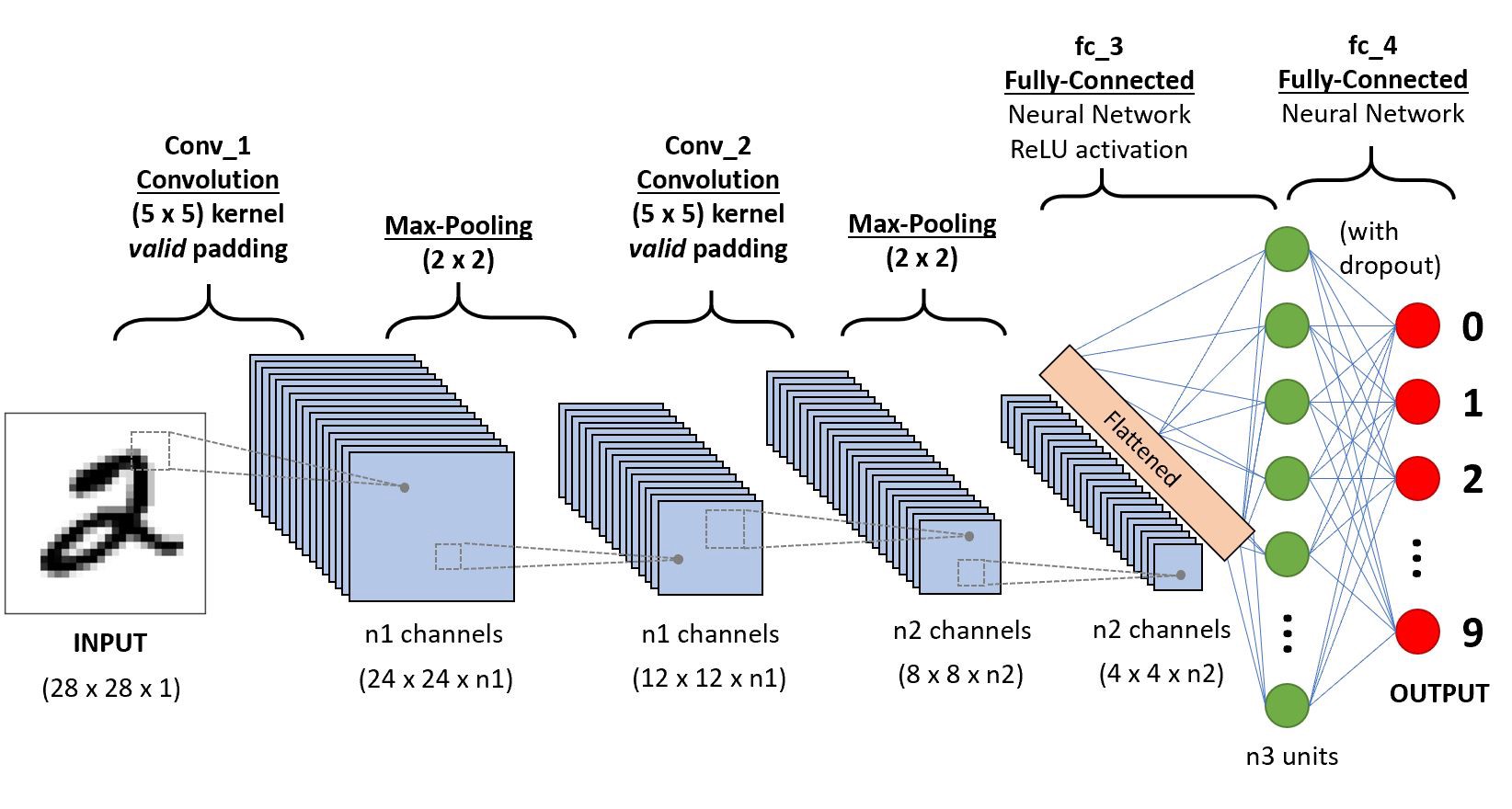

Lad os tage et simpelt Convolutional neurale netværk,

Vi vil gå lag-wise for at få dyb indsigt i denne CNN.,

for det Første, er der et par ting at lære fra lag 1, der er skridte og polstring, vi vil se, hver af dem kort med eksempler

Lad os antage, at dette i input-matrix på 5×5 og et filter af 3X3 matrix, for dem, der ikke ved, hvad et filter er et sæt af vægte i en matrix, der anvendes på et billede eller en matrix for at få de nødvendige funktioner, søg på foldning hvis dette er din første gang!

Bemærk: Vi tager altid summen eller gennemsnittet af alle værdierne, mens vi laver en konvolution.,

et filter kan være af en hvilken som helst dybde, hvis et filter har en dybde d det kan gå til en dybde af D lag og convolute i.,”f4a6da248a”>

Her er input af størrelsen 5×5 efter anvendelse af en 3×3-kernen eller filtre, som du få en 3×3-udgang funktion kort, så lad os prøve at formulere dette

.png)

Så output højde er formuleret, og det samme med o/s bredde også…

Padding

Mens anvendelse af vindinger vi vil ikke opnå output dimensioner er de samme som input, vi vil miste data over grænser, så tilføjer vi en kant af nuller og genberegne foldning, der dækker alle de input værdier.,r bredde også

Skridte

Nogle gange har vi ikke ønsker at indfange alle de data eller oplysninger til rådighed, så vi kan springe nogle omkringliggende celler lad os visualisere det,

Her input matrix eller et billede er af dimensioner 5×5 med et filter af 3×3, og en skridtlængde på 2, så hver gang vi springe to kolonner og convolute, lad os formulere dette

.png)

Hvis dimensioner er i float-du kan tage ceil() på output-jeg.,e (næste tæt heltal)

Her H refererer til højden, så produktionen højde er formuleret, og det samme med o/s bredde også, og her 2 er skridtlængde værdi, så du kan gøre det, som S i formler.

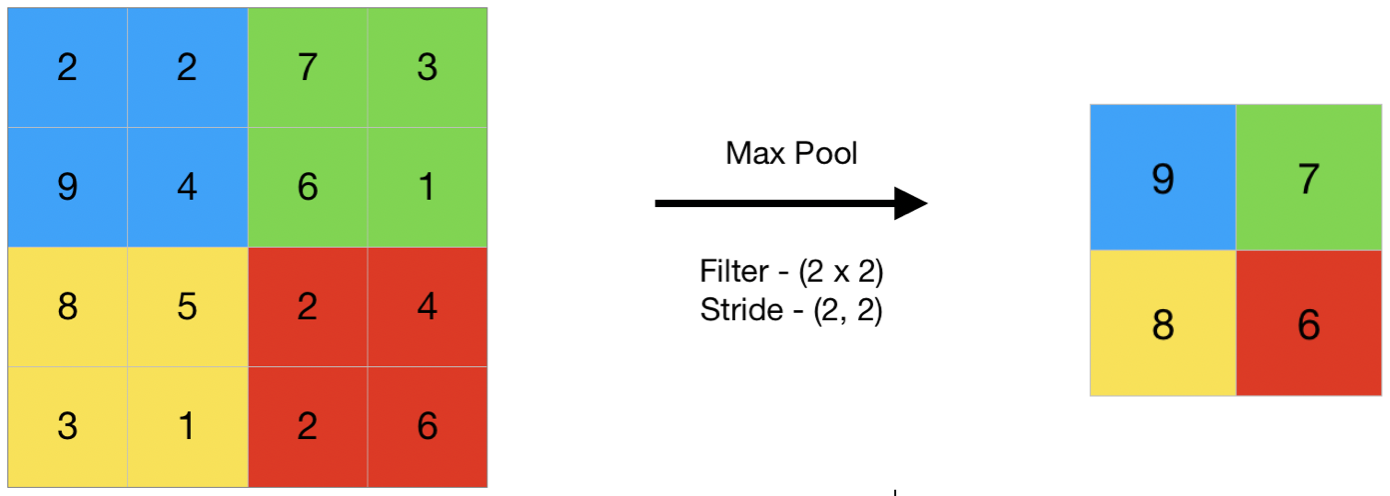

Sammenlægning

I generelle vendinger at samle refererer til en lille del, så her tager vi en lille del af input og forsøge at tage den gennemsnitlige værdi, der er fastsat som den gennemsnitlige sammenlægning eller tage en maksimal værdi, som betegnes som max antal samling, så ved at gøre, at samle på et billede, vi ikke finder ud af alle de værdier, som vi tager en sammenfattet værdi over alle de værdier, der er til stede !!!,

her er et eksempel på max samle så her at tage et skridt af to, vi tager den maksimale værdi, der findes i matrix

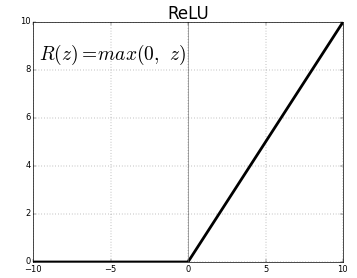

Aktivering funktion

Aktivering funktion er en knude, der er lagt i slutningen af eller i mellem Neurale Netværk. De hjælper med at afgøre, om neuronen ville fyre eller ej., Vi har forskellige typer af aktivering funktioner lige som i ovenstående figur, men for dette indlæg, mit fokus vil være på Udbedret Lineær Enhed (ReLU)

Don ‘ t drop dine kæber, dette er ikke så kompliceret denne funktion blot returnerer 0, hvis din værdi er negativ, ellers vender det tilbage til den samme værdi, du gav intet, men eliminerer negative resultater og fastholder værdier mellem 0 til +infinity

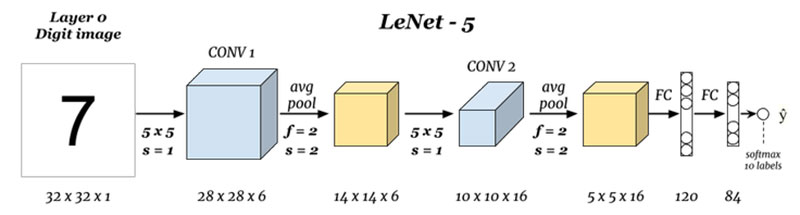

Nu, at vi har lært alle de grundlæggende behov for lad os undersøge en grundlæggende neurale net kaldet LeNet.,

LeNet-5

før vi starter, vil vi se, hvad arkitekturerne er designet til dato.,staltninger

Hvad er indgange og udgange (Lag 0 og Lag N) :

Her er vi forudsige cifre baseret på input billedet, bemærk, at her billede er af dimensioner højde = 32 pixels, bredde = 32 pixels, og en dybde på 1, så vi kan antage, at det er en gråtone billede eller en sort og hvid en, holde det i tankerne output er en softmax af alle de 10 værdier, her softmax giver sandsynligheder eller nøgletal for alle 10 cifre, vi kan tage de tal som output med højeste sandsynlighed for, eller forhold.,ef5″>

Her er vi, der tager input og foldende med filtre af størrelsen 5 x 5 og dermed producerer et output af størrelsen 28 x 28 check til ovenstående formel til at beregne det output, de ting her er, at vi har taget 6 sådanne filtre, og derfor er dybden af conv1 er 6, hvorfor dens dimensioner, 28 x 28 x 6 nu videregive denne til at samle lag

at Samle 1 (Lag 2) :

.png)

Her tager vi den 28 x 28 x 6 som input og anvende gennemsnitlige sammenlægning af en matrix på 2×2 og en skridtlængde på 2 jeg.,e svæver en 2 x 2 matrix på input og tage gennemsnittet af alle disse fire pixels og hoppe med et spring af 2 kolonner hver gang, hvilket giver 14 x 14 x 6 som output vi er design og samling for hvert lag, så her output dybde er 6

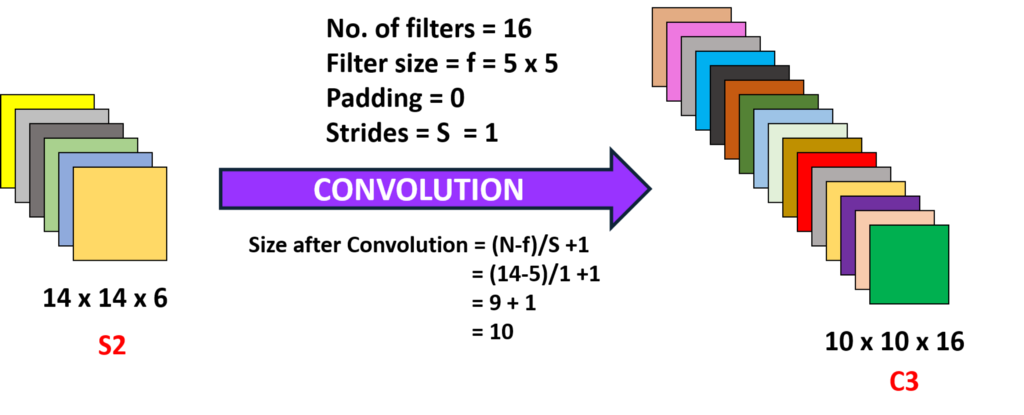

Foldning 2 (Layer-3) :

Her er vi så tage 14 x 14 x 6 jeg.e den tidligere o/s og foldende med et filter af størrelsen 5 x5, med en skridtlængde på 1 jeg.,e (uden spring), og med nul polstring, så vi får et 10 x 10 udgang, nu her, vi er under 16 af sådanne filtre af dybde 6 og foldende således at der opnås et output på 10 x 10 x 16

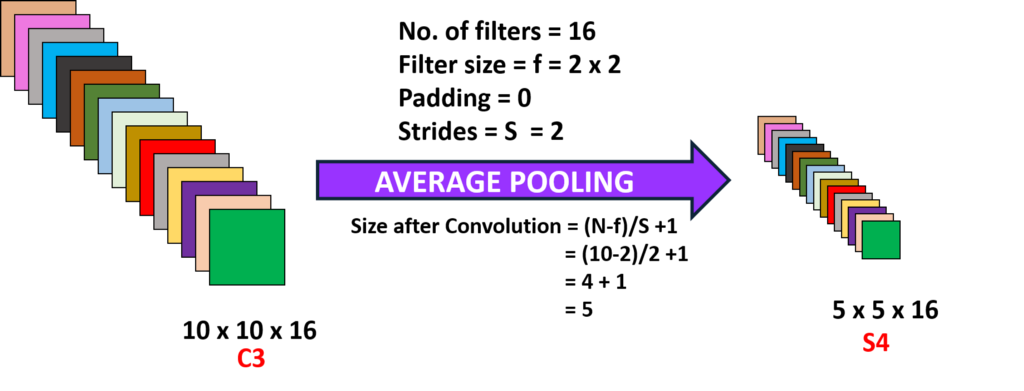

at Samle 2 (Lag 4):

Her er vi under produktionen af det foregående lag og udfører gennemsnitlige sammenlægning med en skridtlængde på 2 jeg.,yer (N-1) :

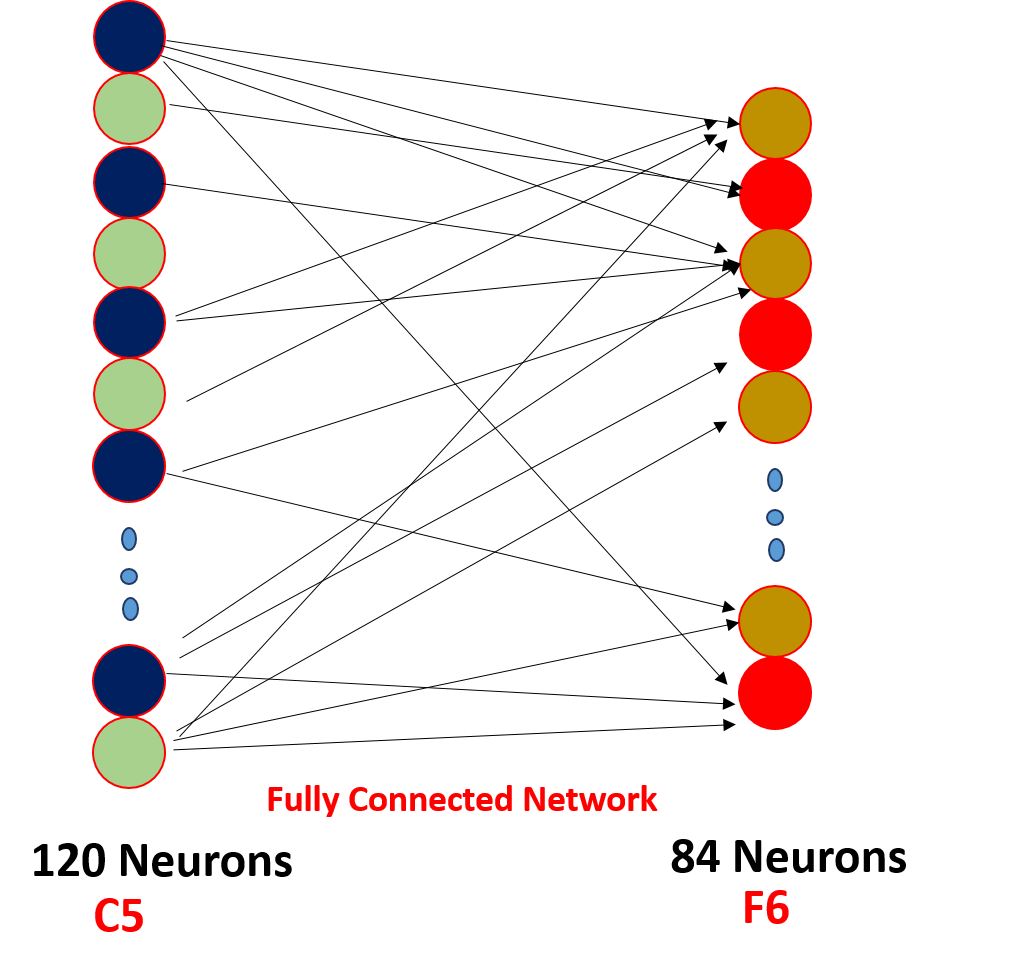

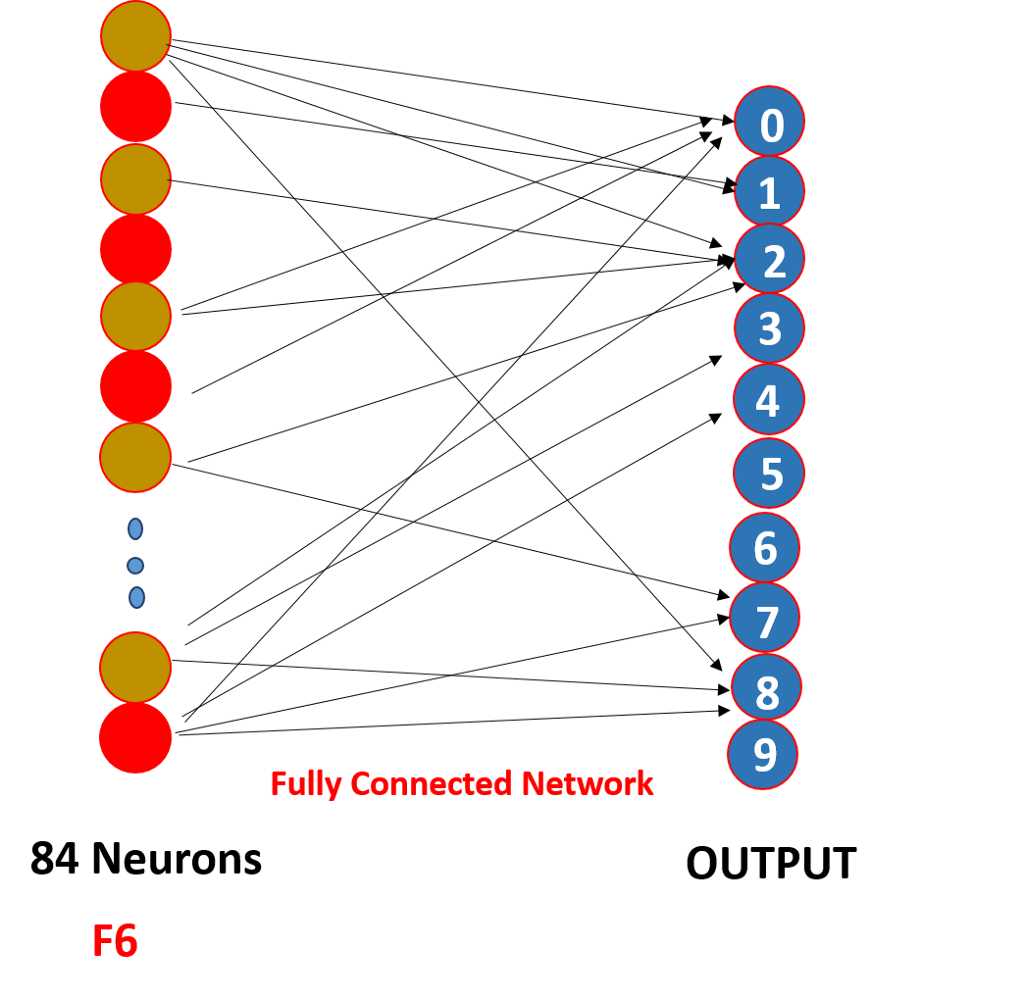

Endelig, vi tromle alle de 5 x 5 x 16 et enkelt lag af størrelsen 400 værdier en indtastning dem til et feed-forward neurale netværk af 120 neuroner, der har en vægt matrix af størrelse og et skjult lag af 84 neuroner forbundet af 120 neuroner med en vægt matrix af, og disse 84 neuroner faktisk er tilsluttet et 10 output neuroner.

Disse o/p neuroner færdiggøre den forudsagte antal af softmaxing .,

Hvordan fungerer et Konvolutionelt neuralt netværk faktisk?,

Det virker gennem en vægt deling og sparsom forbindelse,

.png)

Så her, som du kan se foldning har nogle vægte disse vægte er fælles for alle de input neuroner, ikke hver indgang har en separat vægt kaldes vægt deling, og det er ikke alle input neuroner er forbundet til output neuron et ‘ o kun nogle, som er indviklet er fyret kendt som sparsomme forbindelse, CNN er ikke anderledes fra feed-forward neurale netværk i disse to egenskaber gør dem til noget særligt !!!,

peger på

1. Efter hver foldning udgangen sendes til en aktiveringsfunktion for at opnå bedre funktioner og opretholde positivitet f:: ReLu

2. Sparsom forbindelse og vægtdeling er hovedårsagen til, at et konvolutionelt neuralt netværk fungerer

3. Begrebet vælge en række filtre i mellem lagene og polstring og skridtlængde og filter dimensioner er taget på at gøre en række eksperimenter, skal du ikke bekymre dig om, at fokusere på bygningens fundament, en dag vil du gøre de eksperimenter og opbygge en mere produktive!!!,

Du kan også læse denne artikel på vores mobilapp