mi a konvolúciós neurális hálózati architektúra?

Ez a cikk a Data Science Blogathon részeként jelent meg.

Bevezetés

egy projekten dolgozik a képfelismerésen vagy az Objektumfelismerésen, de nem rendelkeztek az architektúra felépítésének alapjaival?,

ebben a cikkben fogjuk látni, mi convolutional neurális hálózati architektúrák igaz az alapvető, van egy alapvető építészet, mint egy esettanulmány kell alkalmazni a tanulsággal, Az egyetlen előfeltétel az, csak azt kell tudni, hogy konvolúció működik, De ne aggódj, ez nagyon egyszerű !!

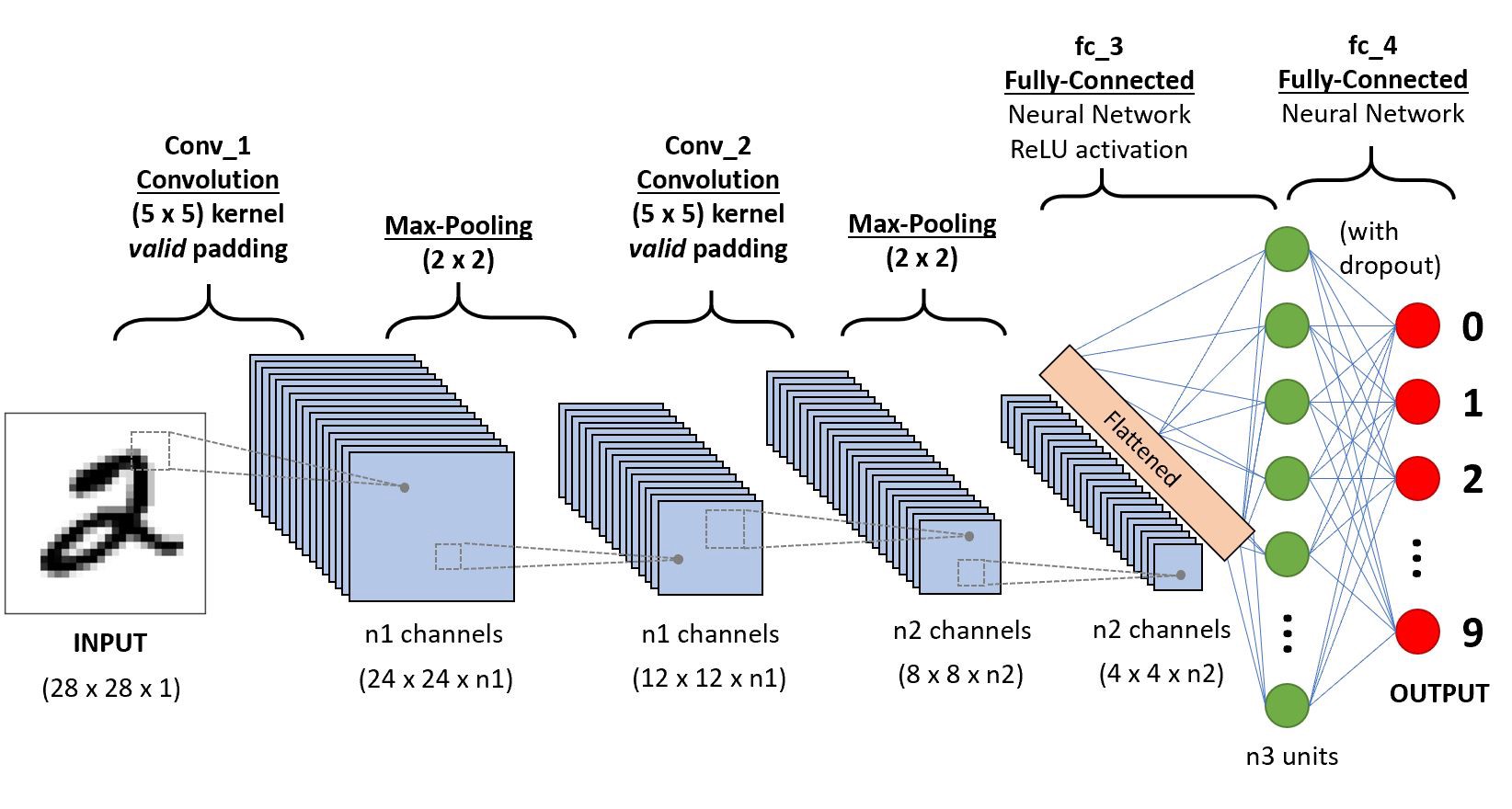

Vegyünk egy egyszerű konvolúciós neurális hálózatot,

mély betekintést nyerünk erről a CNN-ről.,

Először is, van egy pár dolgot megtanulni a réteg 1 suhanó, valamint padding, látni fogjuk, minden őket rövid példákkal

tegyük fel, hogy ez a bemeneti mátrix 5×5 szűrő a 3X3 mátrix, azok számára, akik nem tudják, mi a szűrő egy meghatározott súlyok a mátrix alkalmazása, egy kép vagy egy mátrix, hogy szerezze be a szükséges funkciók, kérjük, keresse a konvolúció, ha ez az első alkalom!

megjegyzés: mindig az összes érték összegét vagy átlagát vesszük konvolúció közben.,

a szűrő bármilyen mélységű lehet, ha egy szűrő d mélységű, akkor a d rétegek mélységébe mehet, a konvolute i-be.,”f4a6da248a”>

Itt a bemenet mérete 5×5 alkalmazása után egy 3×3-as kernel, vagy szűrőket beszerezni egy 3×3 a kimenet funkció térkép szóval próbáljuk megfogalmazni, ez

.png)

Tehát a kimeneti magasság fogalmazta meg ugyanezt o/p szélesség is…

Padding

alkalmazása mellett a menetek nem fogjuk megszerezni a kimenet méretek ugyanaz, mint a bemeneti elveszítjük az adatok határok, így mi fűzi hozzá, hogy egy határon, a nullát pedig az újraszámolás a konvolúció, amely minden a bemeneti értékek.,r szélesség is,

Suhanó

Néhány alkalommal nem szeretné megragadni az összes adat vagy információ nem áll rendelkezésre, így kihagyjuk néhány szomszédos sejtek hadd szemléltesse,

Itt a bemeneti mátrix vagy a kép méretei 5×5-szűrő 3×3-as, valamint egy lépés 2 így minden alkalommal, amikor skip két oszlop pedig convolute, hadd megfogalmazni ezt

.png)

Ha a méretek a float vehet ceil() a kimeneti én.,e (next close integer)

itt h a magasságra utal, így a kimeneti magasság megfogalmazódik, és ugyanaz az o / p szélességgel is, itt pedig 2 a lépésérték, így a képletekben S-ként lehet megtenni.

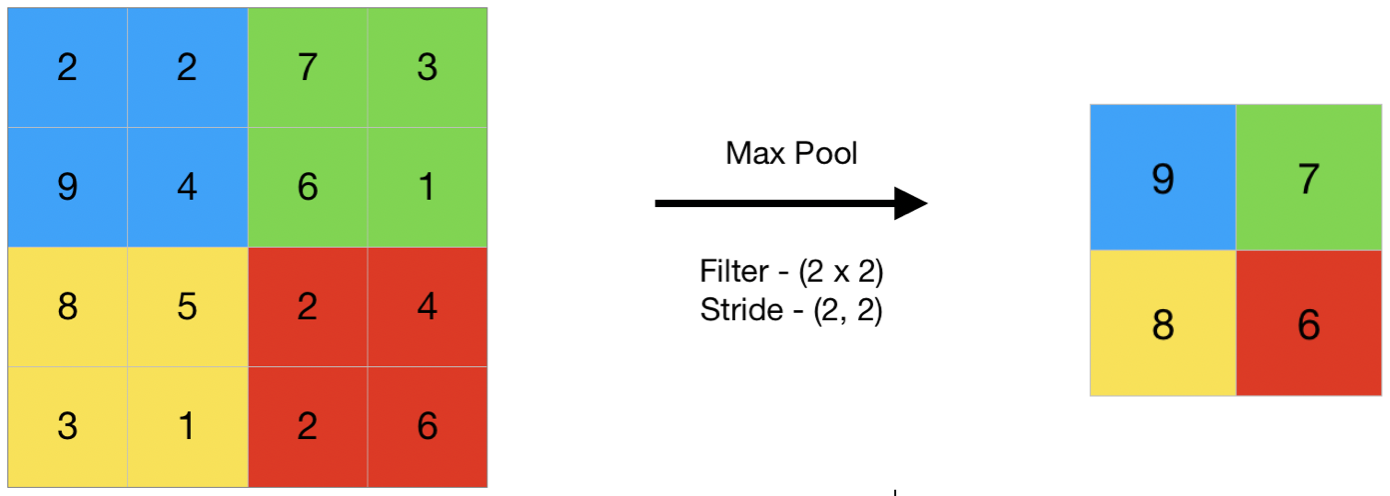

Pooling

Az általános kifejezések összevonása utal, hogy egy kis része, tehát itt egy kis része a bemeneti, majd próbálja meg, hogy az átlagos érték a továbbiakban átlagos összevonása, vagy egy maximális értéket nevezik max összevonása, így ezzel összevonása egy képet, nem vesszük ki az összes értékek teszünk egy összesített érték felett az értékek jelen !!!,

itt egy példa max pooling szóval itt egy lépés, két teszünk a maximális érték jelen van a mátrix

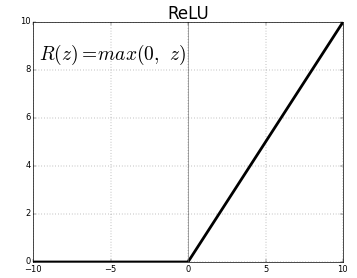

Aktiválás funkció

Az aktiválás funkció a csomópont, amit tesz, végén vagy között Neurális Hálózatok. Segítenek eldönteni, hogy a neuron tüzet okoz-e vagy sem., Különböző típusú aktiválás funkciók ahogy a fenti ábra szerint, de ez a poszt, a hangsúly Finomított Lineáris Egység (ReLU)

Ne dobd el a jaws, ez nem olyan bonyolult ez a funkció egyszerűen 0-t ad vissza, ha az érték negatív, más visszatér ugyanazt az értéket adott, semmit, de megszünteti a negatív kimenet, továbbá fenntartja értékek között 0 +infinity

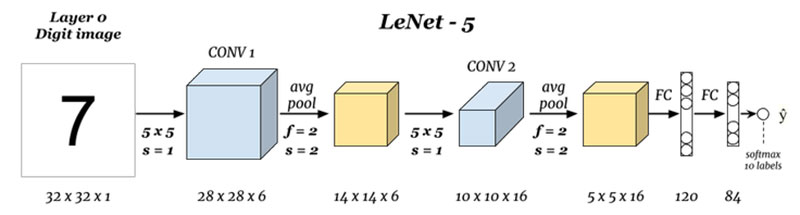

Most, hogy megtudtuk, hogy az alapokat kellett hagyni minket tanulmány alapvető neurális háló nevű LeNet.,

LeNet-5

indulás előtt látni fogjuk, hogy melyek a mai napig tervezett architektúrák.,reform

Mi vagy a bemenetek, mind a kimenetek (Layer 0-Réteg N) :

Itt vagyunk megjósolni számjegy alapján a bemeneti kép adott, vegye figyelembe, hogy itt a kép a méretek magasság = 32 pixel, szélesség = 32 pixel, mélysége 1, tehát feltételezhetjük, hogy ez egy szürkeárnyalatos kép vagy fekete-fehér, tartsa ezt szem előtt tartva a kimenet softmax a 10 érték, itt softmax ad valószínűségek, vagy arányok mind a 10 számjegy, akkor a szám, mint a kimeneti legnagyobb valószínűséggel vagy az arány.,ef5-ös”>

Itt veszünk a bemenet, mind a convoluting a szűrő méret: 5 x 5 ezáltal a termelő kimeneti mérete 28 x 28 ellenőrizze a fenti képlet kiszámításához a kimenet, méretek, a dolog, amit itt vettünk 6 ilyen szűrőket, ezért a mélység conv1 6, ezért a mérete volt, 28 x 28 x 6 most át ezt a pooling réteg

Összevonása 1 (2 Réteg) :

.png)

Itt veszünk a 28 x 28 x 6, mint a bemeneti, illetve alkalmazása átlagos összevonása egy mátrix 2×2, valamint egy lépés 2-én.,e lebeg egy 2 x 2 mátrix a bemenet, mind véve az átlagos, mind a négy pixel, majd ugrás a ugrás a 2 oszlop minden alkalommal, ezáltal 14 x 14 x 6-os kimenet vagyunk számítástechnika a pooling minden réteg, így itt a kimeneti mélysége 6

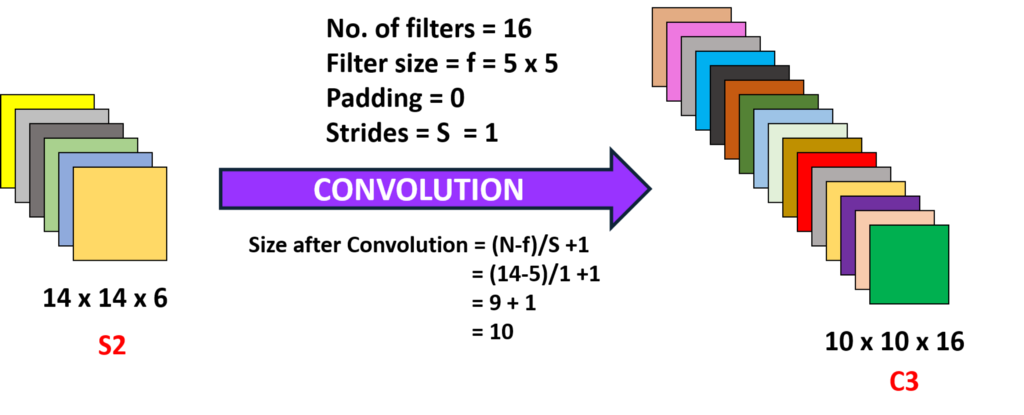

Konvolúció 2 (Layer 3) :

Itt vagyunk véve a 14 x 14 x 6 én.e a korábbi o/p convoluting a szűrő mérete 5 x5, egy lépés 1-én.,e (nincs ugrás), majd nulla paddings így kapunk egy 10 x 10 kimenet, most itt vagyunk véve 16 ilyen szűrőket, a mélység 6 convoluting így megszerzése kimeneti 10 x 10 x 16

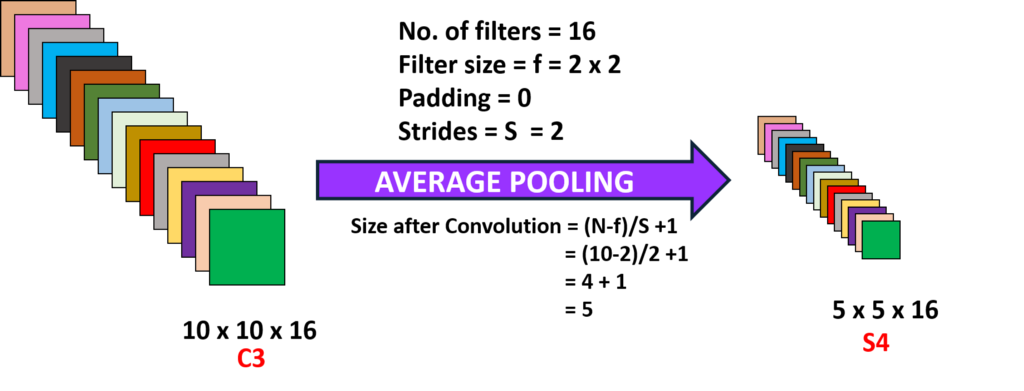

Pooling 2 (Layer 4):

Itt vagyunk véve a termelés az előző réteg teljesítő átlagos összevonása egy lépés 2-én.,a (N-1) :

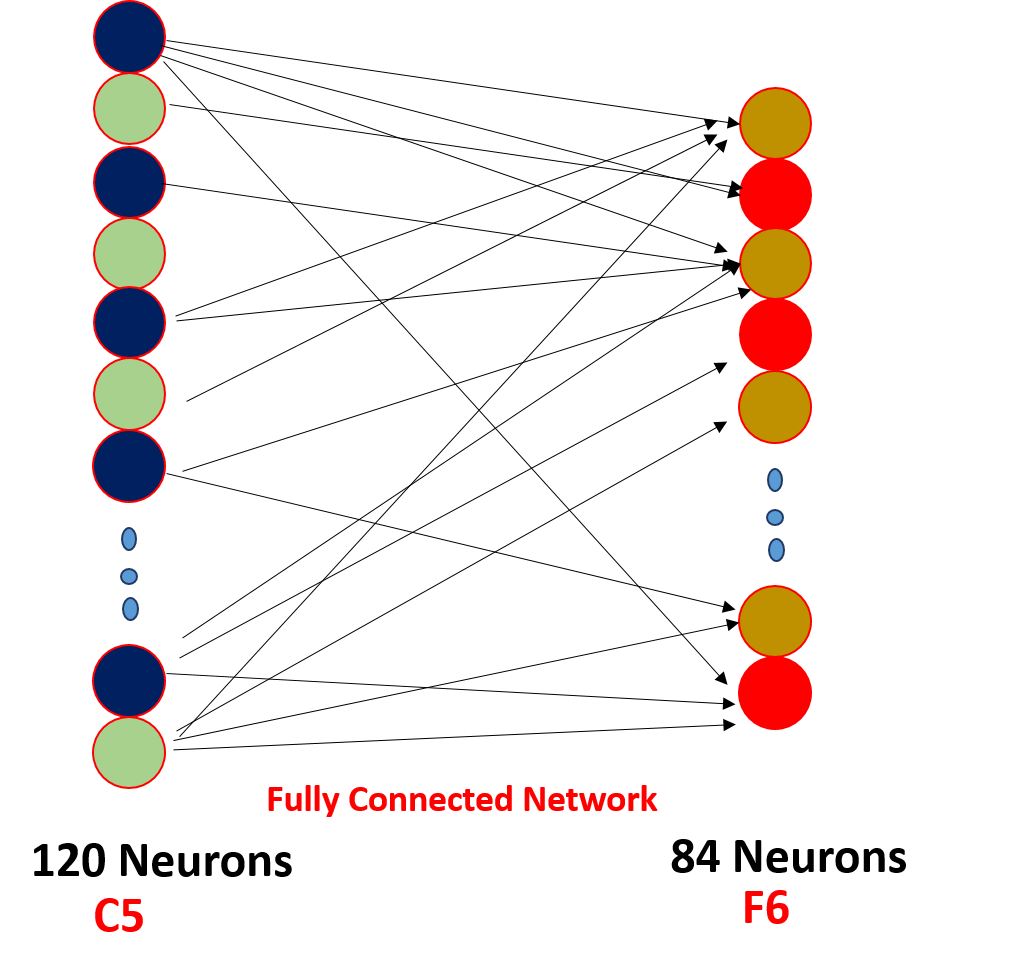

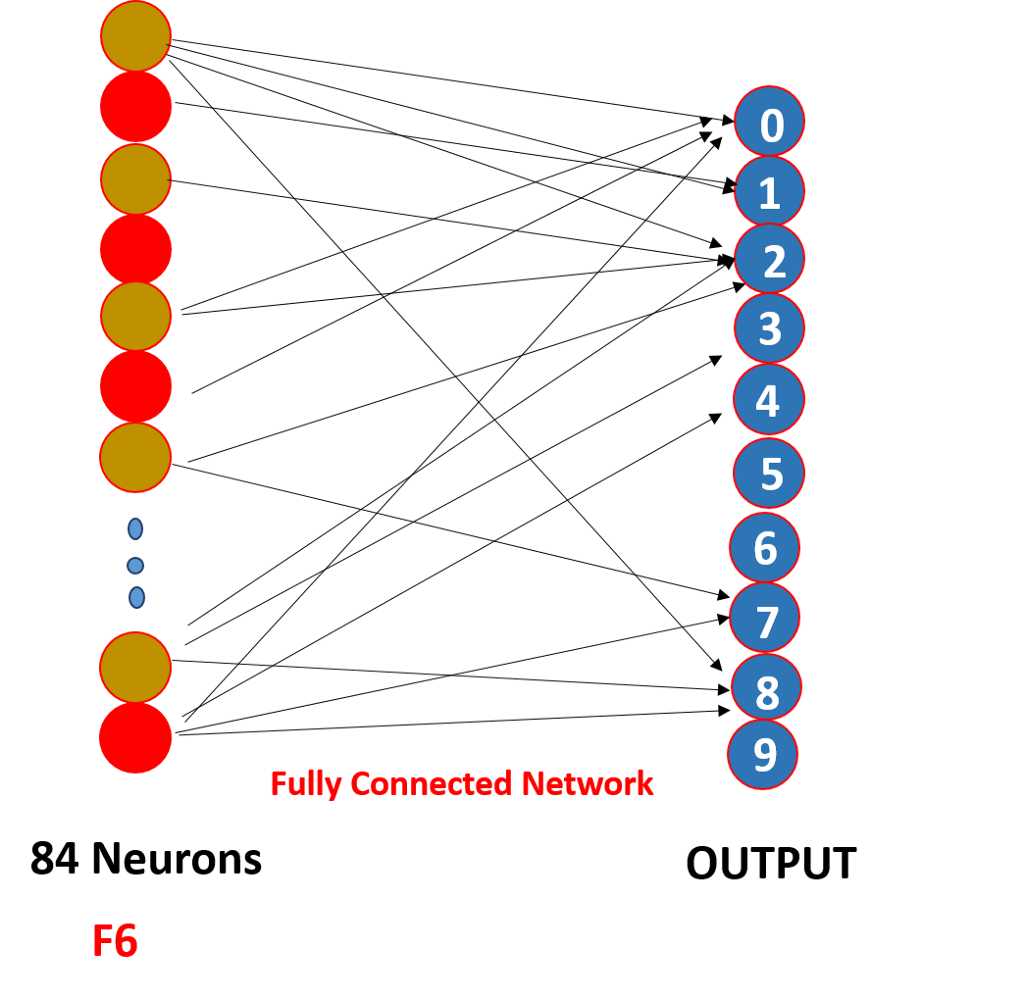

Végre, lelapítjuk mind az 5 x 5 x 16 egyetlen réteg méret 400 értékek egy bevitelüket, hogy egy takarmány-előre neurális hálózat 120 neuronok, hogy egy tömeg mátrix mérete, valamint egy rejtett réteg 84 neuron kapcsolódik a 120 neuronok súllyal mátrix ezek 84 neuronok valóban csatlakozik egy 10 kimeneti neuronok

Ezek az o/p neuronok véglegesíteni a becsült száma alapján softmaxing .,

hogyan működik a konvolúciós neurális hálózat?,

működik át súly megosztás gyér kapcsolatok,

.png)

itt Tehát mint látható, a konvolúció van egy kis súlyok ezek a súlyok által megosztott mind a bemeneti neuronok, nem minden bemenet külön súlyt úgynevezett súly megosztás nem minden bemeneti neuronok csatlakozik az output neuron egy ‘ o csak néhány, amely szövevényes vagy rúgva ismert, mint gyér kapcsolatok, a CNN nem különbözik a takarmány-előre neurális hálózatok a két tulajdonságai teszik különleges !!!,

1. Minden konvolúció után a kimenetet aktiválási funkcióba küldjük, hogy jobb funkciókat kapjunk, és fenntartsuk a pozitivitást pl.: ReLu

2. A ritka kapcsolódás és a tömegmegosztás a fő oka annak, hogy egy konvolúciós neurális hálózat

3-ra működjön. A koncepció a választott számos szűrő rétegek között, padding, lépés és szűrő méretek veszik csinál egy sor kísérletezés, ne aggódj, hogy, összpontosít épület alapja, egyszer meg fogja csinálni ezeket a kísérleteket, és építeni egy produktívabb egyet!!!,

ezt a cikket a