Qual è l’architettura di rete neurale convoluzionale?

Questo articolo è stato pubblicato come parte del Blogathon Data Science.

Introduzione

Lavorare su un progetto sul riconoscimento di immagini o il rilevamento di oggetti, ma non aveva le basi per costruire un’architettura?,

In questo articolo, vedremo quali sono le architetture di rete neurale convoluzionali fin da basic e prenderemo un’architettura di base come caso di studio per applicare i nostri apprendimenti, L’unico pre-requisito è che devi solo sapere come funziona la convoluzione Ma non preoccuparti è molto semplice !!

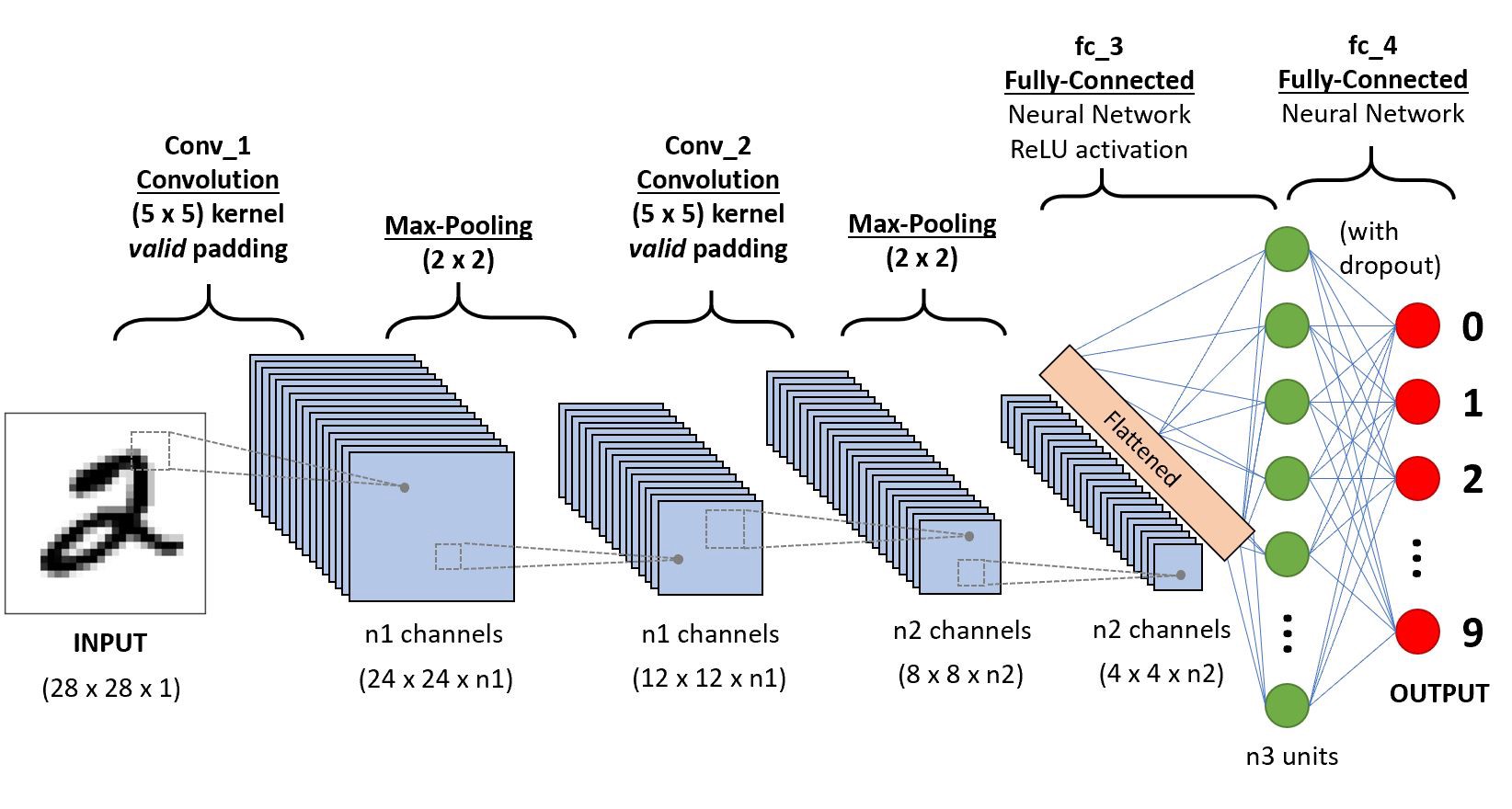

Prendiamo una semplice rete neurale convoluzionale,

Andremo a livello per ottenere approfondimenti su questa CNN.,

in Primo luogo, ci sono un paio di cose da imparare dal livello 1 che è striding e imbottitura, vedremo ciascuno di essi in breve con esempi

supponiamo questo in input una matrice 5×5 e un filtro di matrice 3X3, per coloro che non sanno cosa sia un filtro è un set di pesi in una matrice applicato su un’immagine o una matrice per ottenere le caratteristiche richieste, si prega di cercare di convoluzione, se questa è la tua prima volta!

Nota: Prendiamo sempre la somma o la media di tutti i valori mentre facciamo una convoluzione.,

Un filtro può essere di qualsiasi profondità, se un filtro ha una profondità d può andare a una profondità di strati d e convolare i.,”f4a6da248a”>

Qui l’ingresso è di dimensioni 5×5 dopo l’applicazione di un 3×3 kernel o filtri ottenere un 3×3 output funzionalità della mappa in modo proviamo a formulare questo

.png)

l’altezza di output è formulato con o/p larghezza anche…

Imbottitura

Mentre l’applicazione di elucubrazioni, non otterremo le dimensioni di output lo stesso ingresso si perderanno i dati sui confini così aggiungiamo un bordo di zeri e di ricalcolare la convoluzione, a copertura di tutti i valori di input.,r larghezza anche

Striding

Alcune volte non vogliamo per l’acquisizione di tutti i dati o le informazioni disponibili in modo facciamo un salto di alcune cellule vicine cerchiamo di visualizzare,

di seguito la matrice di input o l’immagine è di dimensioni 5×5 con filtro di 3×3 e un passo di 2, quindi ogni volta che facciamo un salto di due colonne e convolute, consentono di formulare questo

.png)

Se le dimensioni sono in float si può prendere ceil() in uscita io.,e (next close integer)

Qui H si riferisce all’altezza, quindi l’altezza di uscita è formulata e la stessa con o/p width anche e qui 2 è il valore del passo in modo da poterlo fare come S nelle formule.

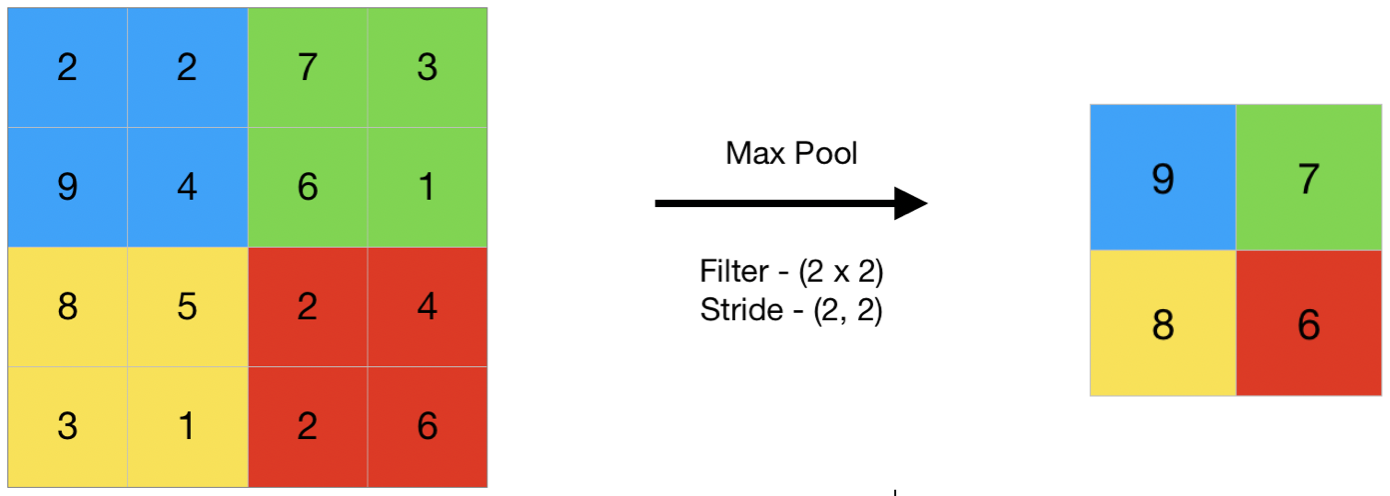

Pooling

In termini generali il pooling si riferisce a una piccola porzione, quindi qui prendiamo una piccola porzione dell’input e proviamo a prendere il valore medio indicato come pooling medio o prendiamo un valore massimo definito come pooling massimo, quindi facendo pooling su un’immagine non stiamo eliminando tutti i valori stiamo prendendo un valore riassunto su tutti i valori presenti !!!,

ecco questo è un esempio di max pooling così qui un passo di due stiamo prendendo il valore massimo presente nella matrice

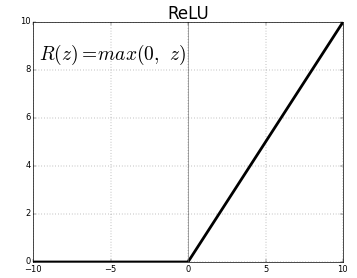

funzione di Attivazione

La funzione di attivazione è un nodo che viene messo alla fine o tra Reti Neurali. Aiutano a decidere se il neurone avrebbe sparato o no., Ci sono diversi tipi di funzioni di attivazione come nella figura sopra, ma per questo post, la mia attenzione sarà Rettificato Unità Lineare (ReLU)

non lasciare cadere le mascelle, questo non è che il complesso di questa funzione restituisce 0 se il valore è negativo, altrimenti restituisce lo stesso valore che hai dato, nulla, ma elimina uscite negative e mantiene valori tra 0 a +infinito

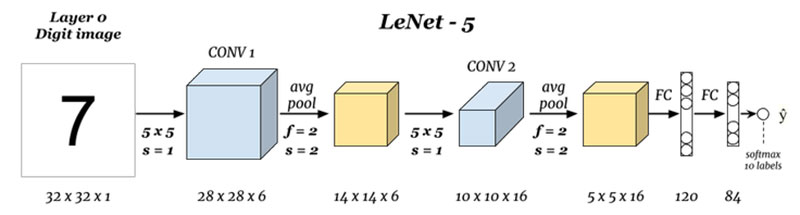

Ora, che abbiamo imparato tutte le basi necessarie cerchiamo di studiare una base neurale rete chiamata LeNet.,

LeNet-5

Prima di iniziare vedremo quali sono le architetture progettate fino ad oggi.,ures

Quali sono gli ingressi e le uscite (Livello 0 e Livello N) :

Qui ci sono predire cifre base dell’immagine di input dato, nota che qui l’immagine è di dimensioni altezza = 32 pixel, larghezza = 32 pixel e una profondità di 1, quindi si può supporre che si tratta di una immagine in scala di grigi o in bianco e nero, tenendo a mente l’uscita è un softmax di tutti e 10 i valori, qui softmax dà la probabilità o di rapporti per tutte le 10 cifre, siamo in grado di prendere il numero in uscita con la più alta probabilità o rapporto.,ef5″>

Qui stiamo prendendo in ingresso e avvitandosi con filtri di dimensione 5 x 5 producendo un output di dimensioni 28 x 28 controllare la formula per calcolare le dimensioni di output, la cosa qui è che abbiamo preso 6 filtri e quindi la profondità di conv1 è 6, quindi le sue dimensioni erano, 28 x 28 x 6 ora passare questo per il pool di livello

il Pool 1 (Livello 2) :

.png)

Qui stiamo prendendo il 28 x 28 x 6 come input e l’applicazione di media pool di una matrice 2×2 e un passo di 2 i.,e in bilico a 2 x 2 matrici in ingresso e prendendo la media di tutti coloro quattro pixel e saltando con un salto di 2 colonne, ogni volta dando 14 x 14 x 6, in uscita ci sono computing il pool di connessioni per ogni strato in modo, qui la profondità di output è di 6

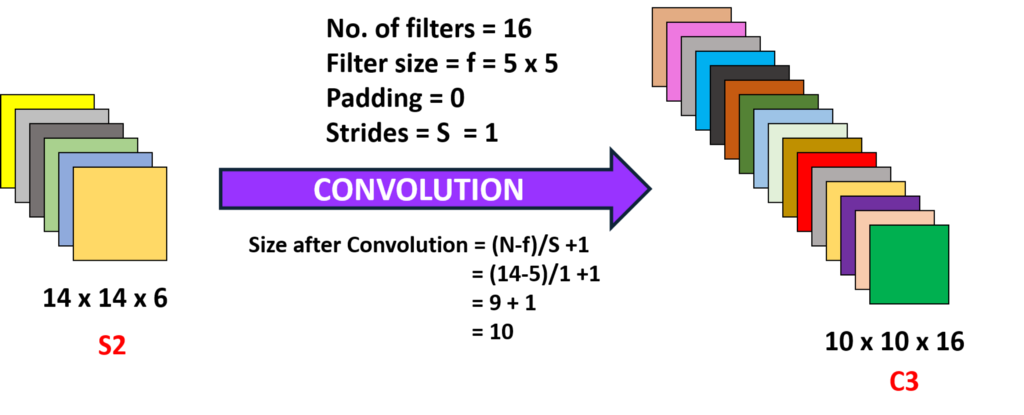

Convoluzione 2 (Livello 3) :

Qui stiamo prendendo il 14 x 14 x 6 mi.e le precedenti o/p e avvitandosi con un filtro di dimensione 5 x5, con un passo di 1 io.,e (senza saltare), e con zero imbottiture in modo da ottenere un 10 x 10 in uscita, ora siamo qui a prendere 16 filtri di profondità 6 e avvitandosi ottenendo così una produzione di 10 x 10 x 16

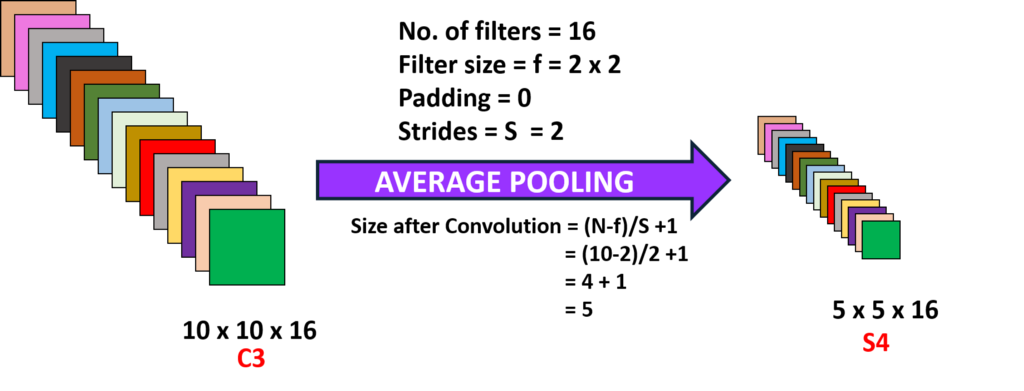

Pool 2 (Livello 4):

Qui stiamo prendendo l’uscita del livello precedente e performing media pool con un passo di 2 i.,yer (N-1) :

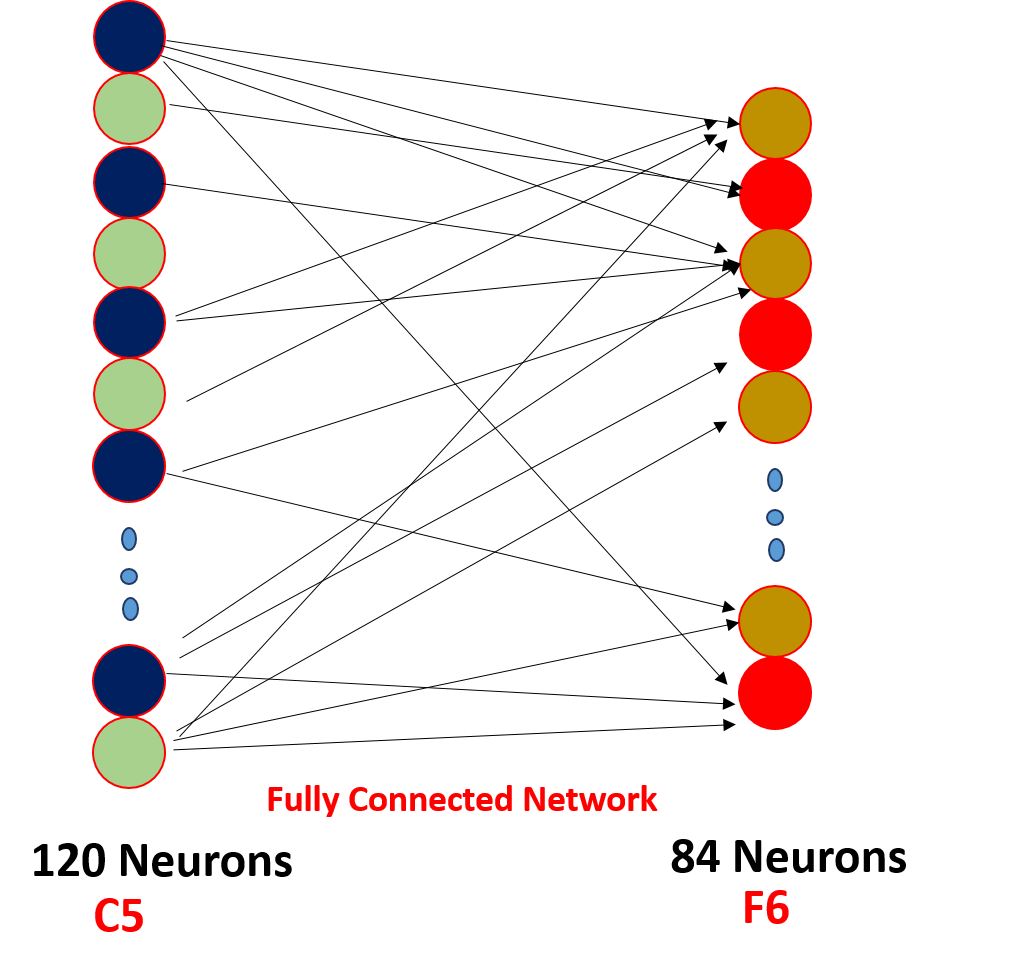

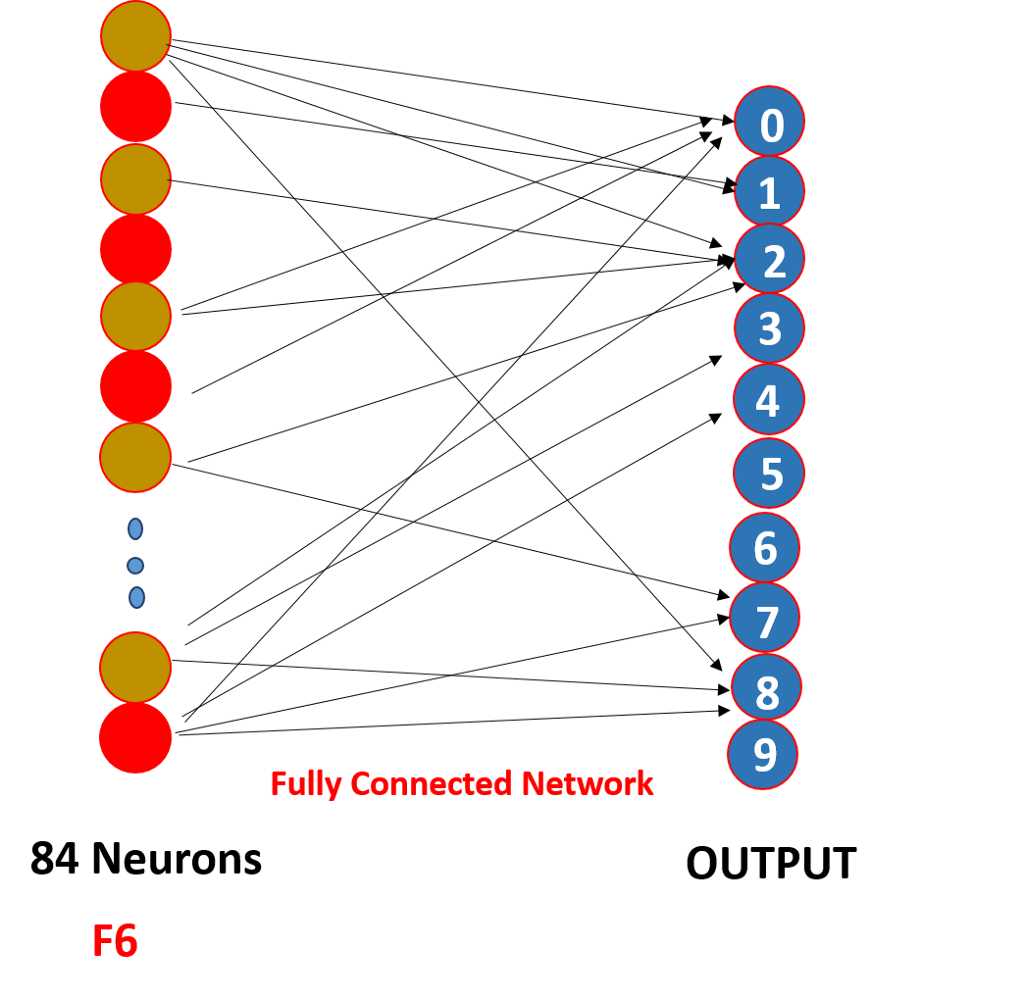

Infine, abbiamo appiattire tutti e 5 x 5 x 16 per un singolo strato di dimensioni 400 valori di un loro inserimento di una rete neurale feed-forward di 120 neuroni avendo una matrice di peso e dimensioni di un livello nascosto di 84 neuroni collegati da 120 neuroni con una matrice di peso e di questi 84 neuroni, infatti, sono collegati a un 10 neuroni di output

Questi o/p neuroni finalizzare il predetto numero di softmaxing .,

Come funziona effettivamente una rete neurale convoluzionale?,

funziona peso attraverso la condivisione e con scarsa connettività,

.png)

Quindi, qui, come si può vedere la convoluzione ha alcuni pesi di questi pesi sono condivisi da tutti i neuroni di input, non ogni ingresso ha un separato peso chiamato peso di condivisione, e non tutti i neuroni di input sono collegati al neurone di output di una o solo di alcune che sono contorto sono sparato noto come sparse connettività, la CNN non è diverso da neurale feed-forward reti di queste due proprietà che li rendono speciali !!!,

Punti da guardare

1. Dopo ogni convoluzione l’output viene inviato ad una funzione di attivazione in modo da ottenere caratteristiche migliori e mantenere la positività es: ReLu

2. La connettività sparsa e la condivisione del peso sono la ragione principale per cui una rete neurale convoluzionale funziona

3. Il concetto di scegliere un numero di filtri tra strati e imbottitura e falcata e filtro dimensioni sono prese a fare una serie di sperimentazioni, non preoccuparti di questo, concentrarsi sulla costruzione di fondazione, un giorno si farà quegli esperimenti e costruire uno più produttivo!!!,

Puoi anche leggere questo articolo sulla nostra APP mobile