とはConvolutional神経ネットワークアーキテクチャー?

この記事はData Science Blogathonの一部として公開されました。

はじめに

画像認識または物体検出に関するプロジェクトに取り組んでいますが、アーキテクチャを構築するための基本がありませんで,

この記事では、私たちは右の基本から畳み込みニューラルネットワークアーキテクチャが何であるかを見ていきますし、我々は私たちの学習を適用する!

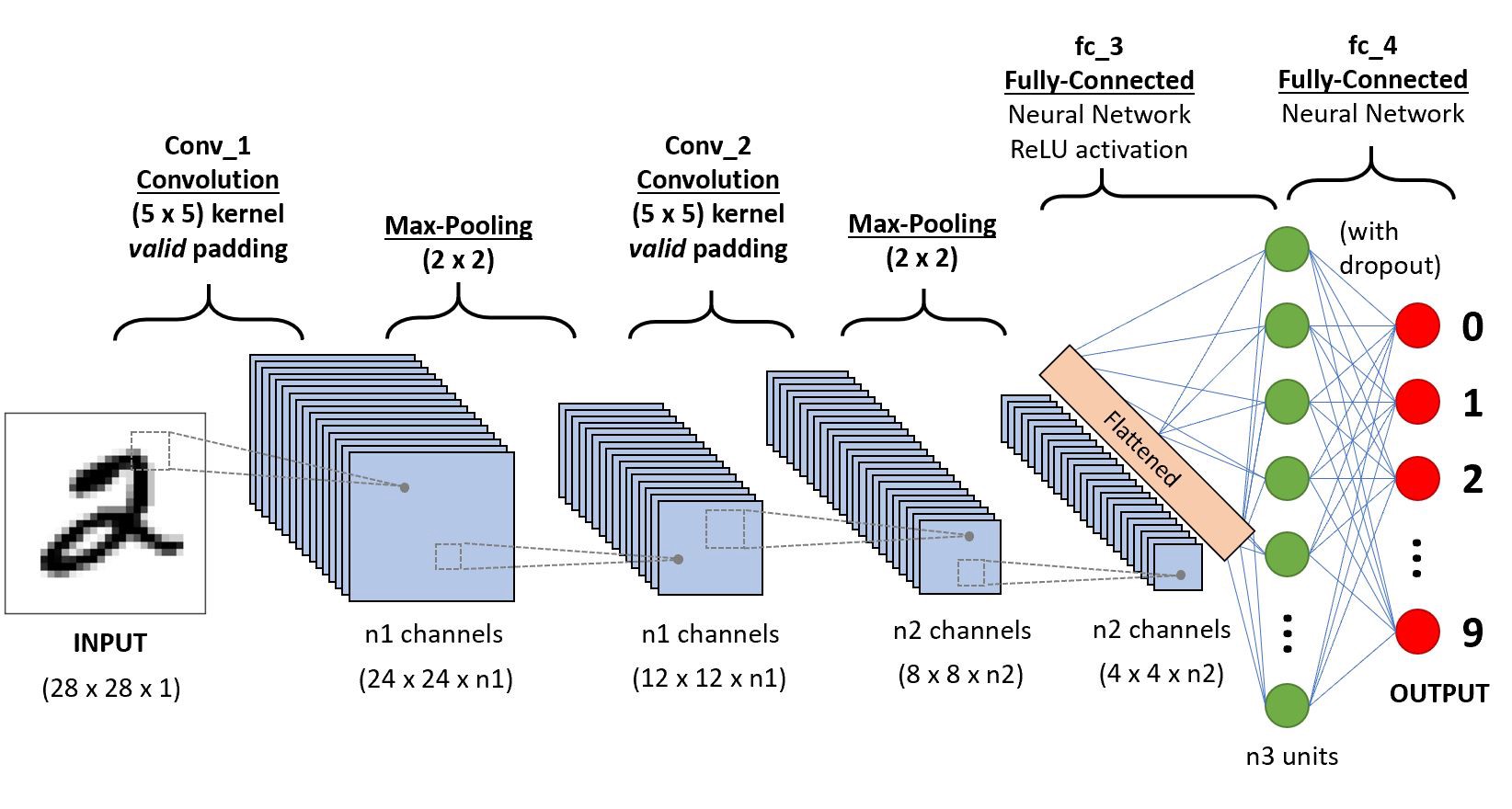

単純な畳み込みニューラルネットワークを考えてみましょう。

このCNNについての深い洞察を得るためにレイヤーワイズに行きます。,

まず、ストライディングとパディングであるレイヤ1から学ぶべきことがいくつかあります。

5×5の入力行列と行列3X3のフィルターでこれを仮定しましょう。フィルターが画像または行列に適用される行列の重みの集合であることがわからない人のために、必要な特徴を得るために、これが初めての場合は畳み込みで検索してください。

注:畳み込みを行っている間は、常にすべての値の合計または平均を取ります。,

フィルターは任意の深さにすることができ、フィルターが深さdを有する場合、それはd層の深さに行き、畳み込むことができるi。,”f4a6da248a”>

ここで、入力は5×5のサイズです3×3カーネルまたはフィルタを適用した後、3×3の出力特徴マップを取得するので、これを定式化してみましょう

.png)

したがって、出力の高さは定式化され、o/p幅も同じです…

padding

畳み込みを適用している間、入力と同じ出力次元は得られません境界上のデータを失うので、ゼロの境界線を追加し、すべての入力値をカバーする畳み込みを再計算します。,r幅も

ストライディング

利用可能なすべてのデータまたは情報をキャプチャしたくない場合があるので、いくつかの隣接するセルをスキップして視覚化しましょう。

ここで入力行列または画像は次元5です×5フィルターが3×3、ストライドが2であるため、二つの列をスキップして畳み込むたびに、これを定式化しましょう

.png)

次元がfloatの場合、出力iにceil()を取ることができます。,e(次の閉じる整数)

ここでHは高さを指すので、出力の高さは定式化され、o/p幅と同じであり、ここで2はストライド値であるため、式の中でSとして作ることができます。

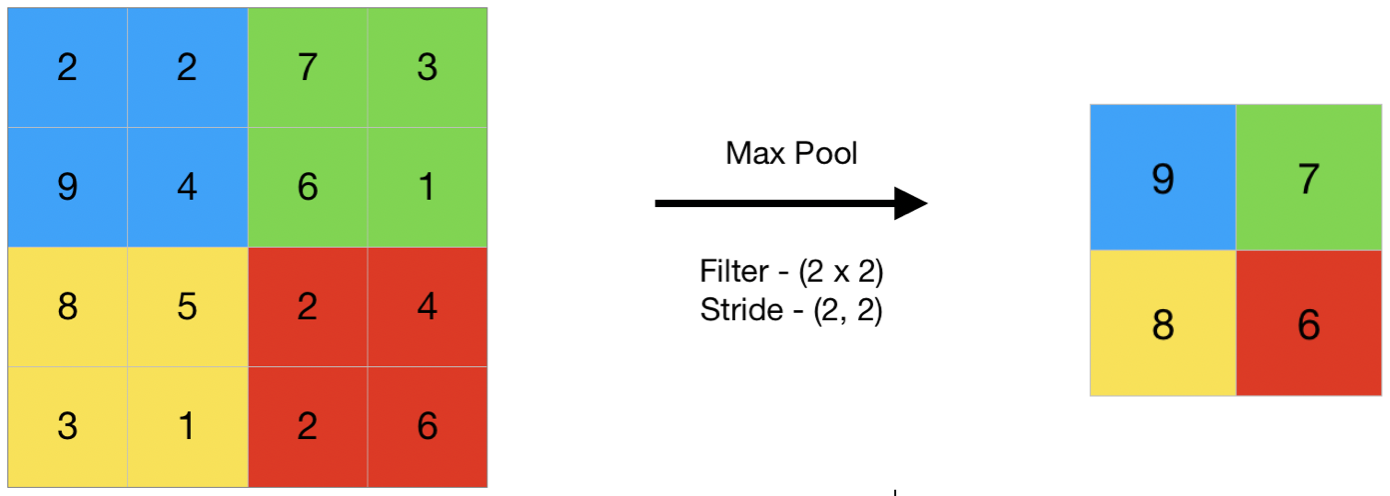

プーリング

一般的には、プーリングは小さな部分を指しますので、ここでは入力の小さな部分を取り、平均プーリングと呼ばれる平均値を取るか、最大プーリングと呼ばれる最大値を取るようにしてください。!!,

ここでは、これは最大プーリングの例ですので、ここでは、行列に存在する最大値を取っています

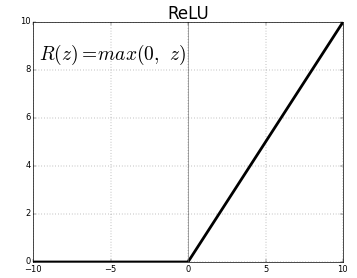

活性化関数

活性化関数は、ネットワーク。 彼らは、ニューロンが発射するかどうかを決定するのに役立ちます。, 上の図のようにさまざまなタイプのアクティベーション関数がありますが、この投稿では、整流された線形単位(ReLU)に焦点を当てます

あなたの顎を落とさないでください、これは複雑ではありませんあなたの値が負の場合、この関数は単に0を返しますそれ以外の場合は同じ値を返します与えました,何もないが、負の出力を排除し、間の値を維持します0へ+無限大

今、私たちは私たちがlenetと呼ばれる基本的なニューラルネットを研究してみましょう必要なすべての基本を学んだこと.,

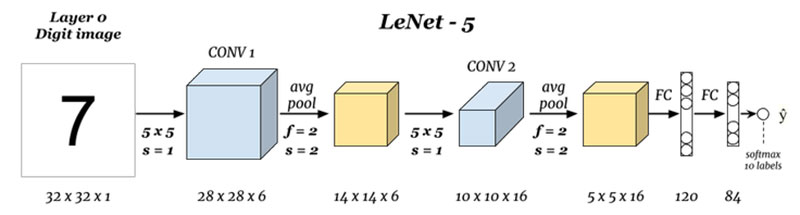

LeNet-5

開始する前に、これまでに設計されたアーキテクチャが何であるかを見ていきます。,ures

入力と出力(レイヤー0とレイヤーn)は何ですか:

ここでは、入力画像に基づいて数字を予測しています。それはグレースケール画像または白黒のものであると仮定することができ、出力はすべての10値のsoftmaxであることを念頭に置いて、ここでsoftmaxはすべての10桁の確率または比率を与えます、我々は最高の確率または比率で出力として数を取ることができます。,ef5″>

ここでは、サイズ5×5のフィルタで入力と畳み込みを行い、サイズ28×28の出力を生成します出力寸法を計算するために上記の式を確認してください、ここでのことは、6つのフィルタを取ったため、conv1の深さは6であるため、28x28x6これをプーリング層に渡します

プーリング1(レイヤー2):

.png)

ここでは、28x28x6を入力として取り、2×2の行列と2iのストライドの平均プーリングを適用しています。,e入力に2×2行列をホバリングし、それらすべてのピクセルの平均を取り、毎回2列のスキップでジャンプするため、出力として14x14x6を与えるため、出力深さは6

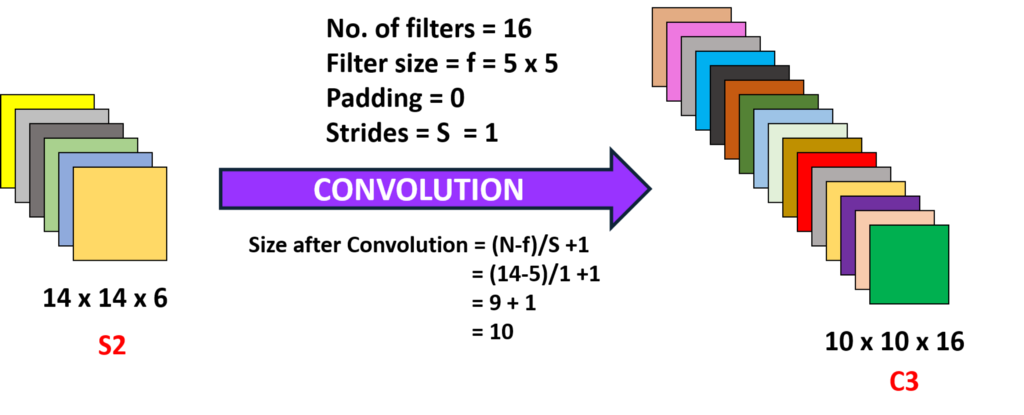

畳み込み2(Layer3):

iv id=”5329338ef5″ここでは、14x14x6、すなわち前のo/pを取り、サイズ5×5のフィルターで畳み込み、ストライドは1iです。,10×10の出力が得られるので、ここでは16の深さ6のフィルターを取り、畳み込むことで10x10x16の出力が得られます

iv id=”5329338ef5″ここでは、14x14x6、すなわち前のo/pを取り、サイズ5×5のフィルターで畳み込み、ストライドは1iです。,10×10の出力が得られるので、ここでは16の深さ6のフィルターを取り、畳み込むことで10x10x16の出力が得られます

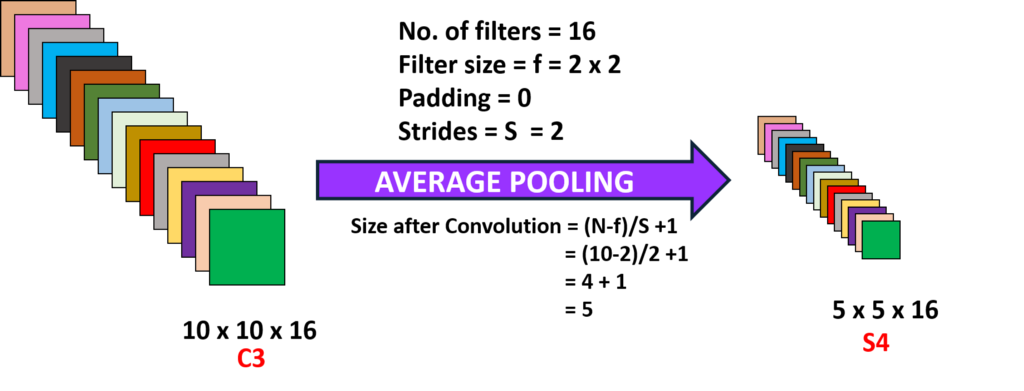

プーリング2(レイヤー4):

ここでは、前の層の出力を取得し、2iのストライドで平均プーリングを実行しています。,yer(N-1):

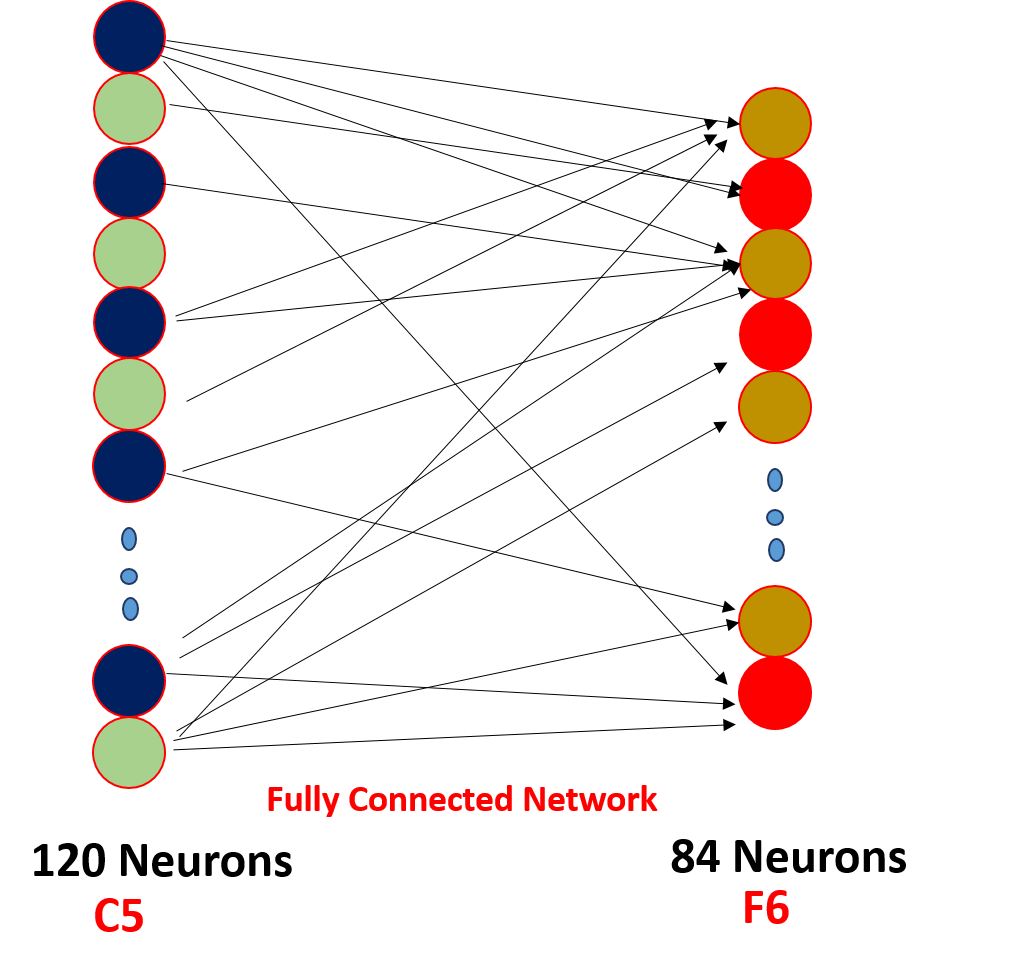

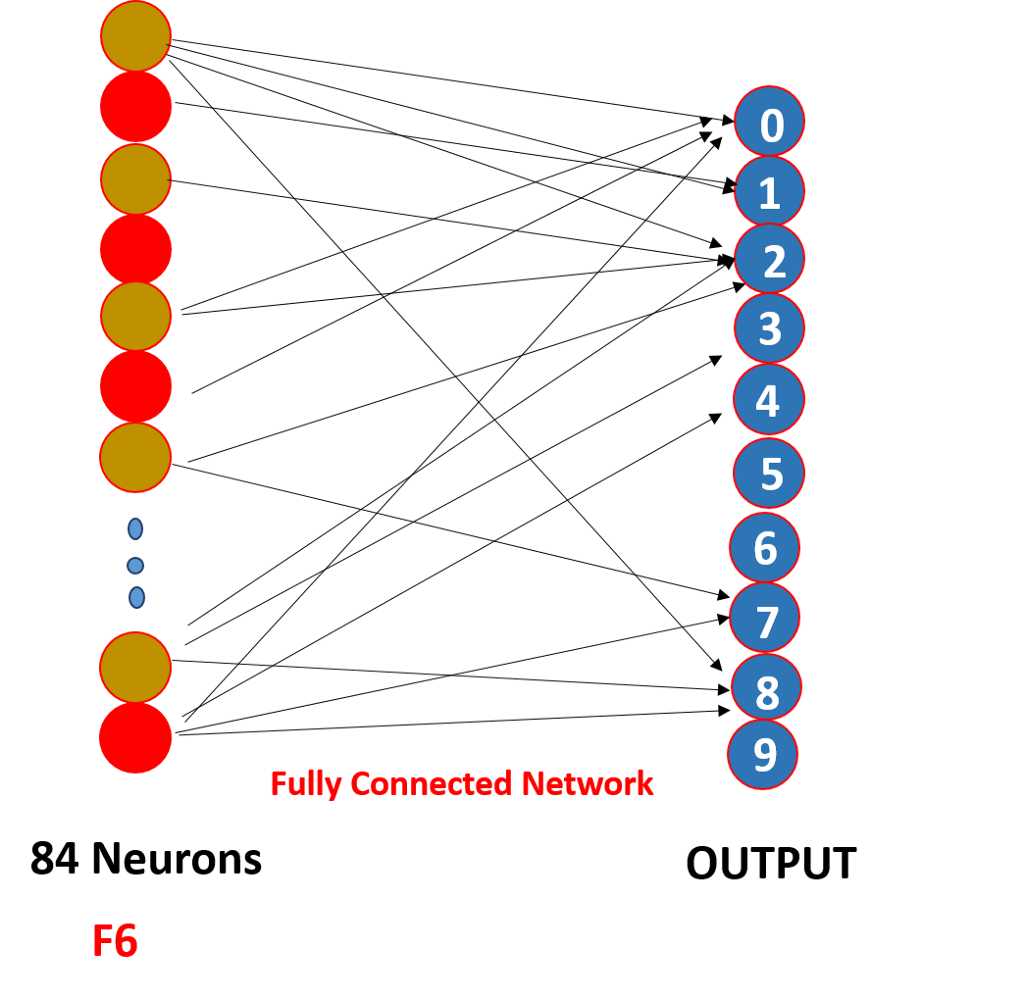

最後に、5x5x16をすべて400個の値の単一レイヤーに平flat化し、120個のニューロンのフィードフォワードニューラルネットワークに入力し、サイズの重み行列と84個のニューロンの隠れ層を120個のニューロンによって接続した。の重み行列とこれらの84ニューロンは実際に10の出力ニューロンに接続されています

これらのo/pニューロンは、ソフトマックス,

畳み込みニューラルネットワークは実際にどのように機能しますか?,

これは、重みの共有とスパース接続を介して動作します,

.png)

だからここであなたが見ることができるように畳み込みは、これらの重みは、すべての入力ニューロンによって共有されているいくつかの重みを持っています,各入力は、重みの共有と呼ばれる別々の重みを持っていません,そして、すべての入力ニューロンが接続されていません,そして、すべての入力ニューロンが接続されています.出力ニューロンa’oは、スパース接続として知られているいくつかのみが発射され、cnnはフィードフォワードニューラルネットワークと変わらないこれら二つのプロパティ!!,

見るべきポイント

1。 すべての畳み込みの後、出力はより良い特徴を得て陽性を維持するように活性化関数に送られます例:ReLu

2。 スパース接続と重みの共有は、畳み込みニューラルネットワークが機能する主な理由です

3. レイヤーとパディングとストライドとフィルターの寸法の間にフィルターの数を選択するという概念は、実験の数を行う上で撮影され、それを心配しない!!,

あなたはまた、私たちのモバイルアプリでこの記事を読むことができます