Convolutional Neural Network Architecture 란 무엇입니까?

이 기사는 데이터 과학 Blogathon 의 일부로 출판되었습니다.

소개

프로젝트에서 작업에 이미지 인식 또는 물체 감지를 나타나지 않는 기초에 건축하는 아키텍처?,

이 문서에서,우리는 것을 볼 수 있는 나선형 신경 네트워크 아키텍처에서 기본 그리고 우리는 기본적인공 사례 연구로 적용하는 우리의 배움,유일한 전제 조건은 당신이는 방법을 알고 있어야 나선 작품이지만 걱정하지 마세요 아주 간단합니다!!

우리는 간단한 나선형의 신경 네트워크,

우리는 레이어를 현명한 깊은 통찰력에 대해 이 CNN.,

첫째,거기에 몇 가지 일들을 배우로서 계층 1 는 스트 라이딩과 패딩을,우리는 그들 각각에서 간단한 예제와 함께

우리 가정이 입력에서 매트릭스의 5×5 필터 매트릭스의 3X3 사람들을 위해,무엇인지 모르는 필터 설정중에서 매트릭스에 적용되는 이미지 또는 매트릭스를 구하는 데 필요한 기능 검색하시기 바랍에 나선다면 이것은 당신의 첫 번째 시간!

참고:우리는 항상 합계 또는 평균의 모든 값을하고있는 동안 회선.,

필터는 임의의 깊이가 될 수 있으며,필터가 깊이 d 를 갖는 경우 d 층의 깊이로 이동하여 i 를 뒤엎을 수 있습니다.,”f4a6da248a”>

여기에서 입력 크기가 5×5 을 적용한 후 3×3 커널이나 필터를 얻 3×3 개출력 기능을지도 그래서 우리는 시도를 수립니다.

.png)

이 출력 높이 공식화되고 동일 o/p 폭도 있습니다…

패딩

을 적용하는 동안 회선 우리는 취득하지 않을 것이라는 것 출력 크기와 동일한 입력 우리는 우리를 잃을 것이 데이터를 통해 국경을 그래서 우리는 추가경 제로하고 다시 계산 회선을 모두 포괄하는 입력 값입니다.,r 폭 또한

월쯤

일부 시 우리가 원하지 않을 캡처하는 모든 데이터 또는 정보 사용할 수 있도록 우리는 일부를 생략 이웃한 세포는 저희가 그것을 시각화,

여기에서 입력 모체 또는 이미지의 크기가 5×5 필터와 함께 3×3stride2 그래서 때마다 우리 건너뛰기 두 열고 나선상, 우리는 이 글

.png)

경우에는 치수에서 부동할 수 있 ceil()를 출력 i.,e(다음 가까운 정수)

여기서 말하는 높이므로,출력 높이 공식화되고 동일 o/p 폭 또한 여기에서 2 개의 보폭 값 그래서 그것을 만들 수 있습니다 S 에 공식.

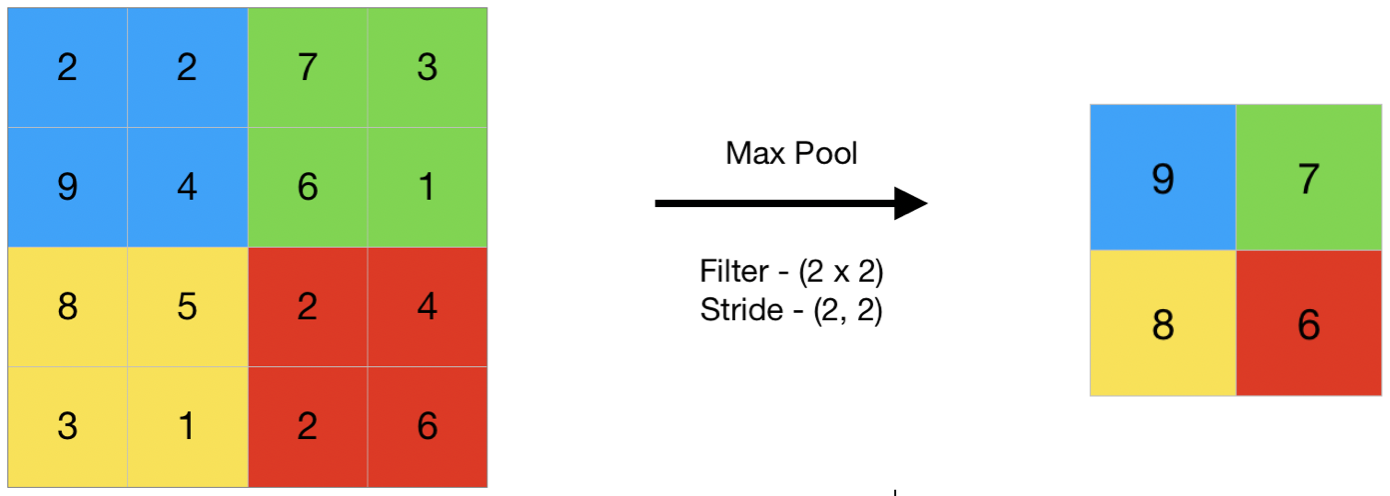

풀링

일반적인 관점에서 풀링을 참조하여 작은 부분은,그래서 여기서 우리는 우리의 작은 부분 입력하려고 걸리는 평균 값이라고도 평균적 풀링을 최대 값으로 불리 max 풀링을 수행하여 있으므로 풀링한 이미지는 우리가 취하지 않는 모든 값을 우리는 값은 요약을 통해 모든 값이 존재!!!,

여기 이것은 예를 들어 최대의 풀 그래서 여기에 복용 보폭의 두 우리는 최대치에서 현재 매트릭스가

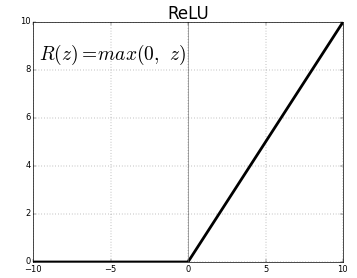

기능을 활성화

활성화 기능이 있는 노드의 마지막에 사용 또는 사이에 신경망이 있습니다. 그들은 뉴런이 발사 될지 아닌지를 결정하는 데 도움을줍니다., 우리는 다른 유형의 기능을 활성화 단 위의 그림에서와 같이지만,이 게시물에 대한 내 초점이 될 것입 정형 장치(ReLU)

떨어지지 않는 당신의 턱 이는 복잡한 이 함수는 단순히 경우 0 을 반환하는 값은 부정적인 다른 그것은 같은 값을 반환합을 준,하지만 아무것도 없는 부정적인 출력을 유지하고 값이 0~+infinity

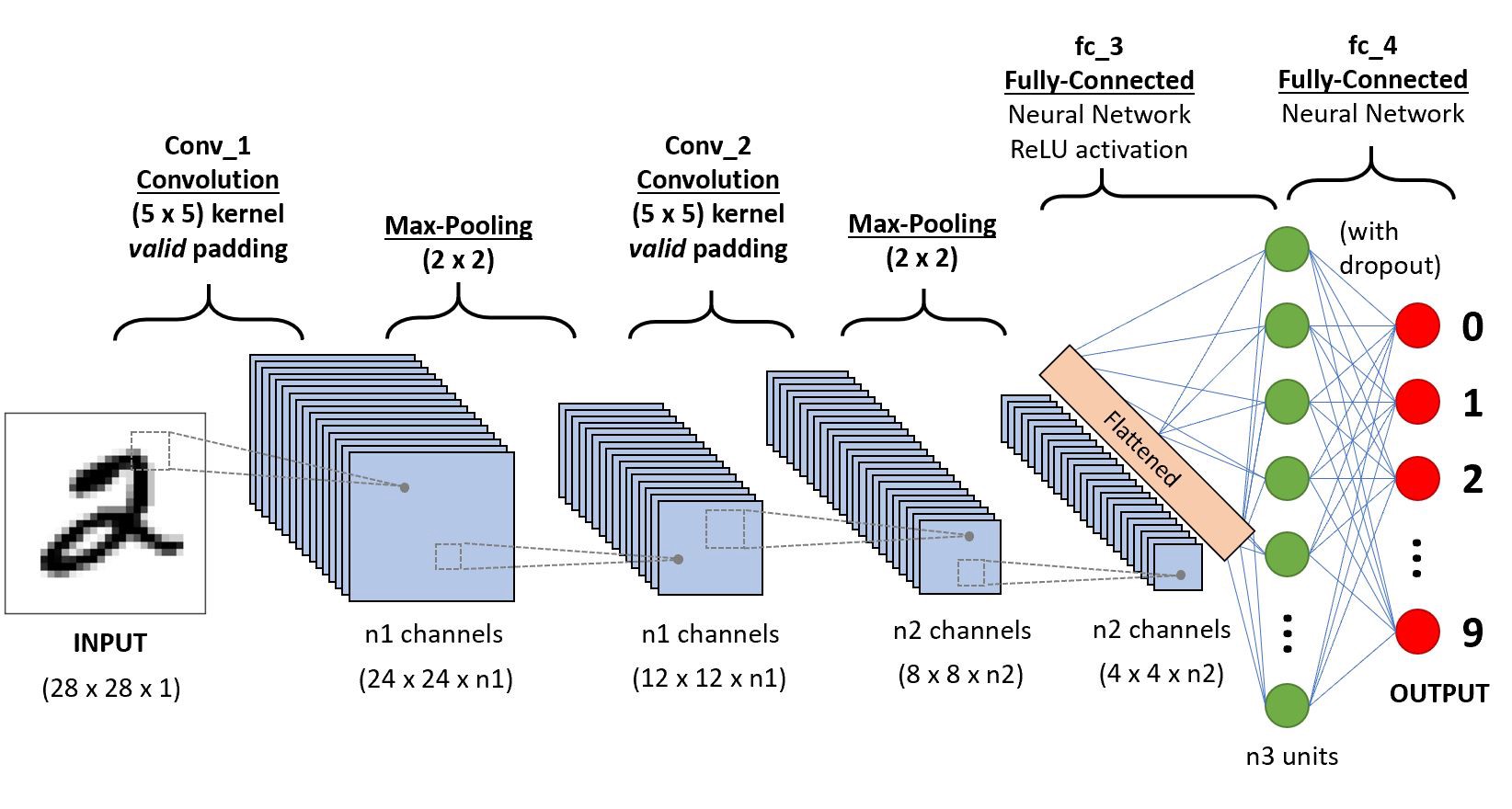

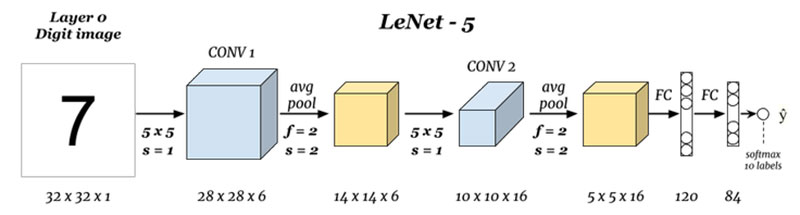

이제,우리는 모든 기초를 필요한 저희의 연구는 기본적인 신경망이라는 LeNet.,

LeNet-5

시작하기 전에 현재까지 설계된 아키텍처가 무엇인지 살펴 보겠습니다.,우레스

은 무엇 입력 및 출력을(Layer0 층 N):

여기서 우리는 예측하는 숫자가 입력한 내용을 기준으로 주어진 이미지,참고로 여기는 이미지의 크기 height=32 픽셀 폭=32 픽셀,그리고 깊이의 1 개,그래서 가정할 수 있습니다 그것은 흑백 이미지 또는 검은색 및 흰색,유지 하는 마음에서 출력은 softmax 의 모든 10 개 값을,여기에 softmax 게 확률이나 비율을 모두 10 자리 숫자로,우리는 번호로 출력이 가장 높은 확률이나 비율이 있습니다.,ef5″>

여기서 우리는 복용 입력 및 convoluting 필터의 크기가 5×5 함으로써 생산 출력의 크기 28×28 일 공식을 확인하려면 위의 계산 출력 크기에,여기서 우리는 6 이러한 필터와 따라서 깊이의 conv1 6,따라서 그것의 치수,28x28x6 지금 이를 풀링 계층

Pooling1(2 층):

.png)

여기서 우리는 28x28x6 개의 입력으로 적용하는 평균의 풀링을 매트릭스의 2×2 의 보폭 2 나.,e 을 유혹 2×2 매트릭스에 입력 및 평균 모든 사람들의 네 개의 픽셀이고 점프로 건너뛰기의 2 열 때마다 따라서 주는 14x14x6 개의 출력으로 우리는 컴퓨팅의 풀링을 위한 모든 계층 그래서 여기에서 출력의 깊이가 6

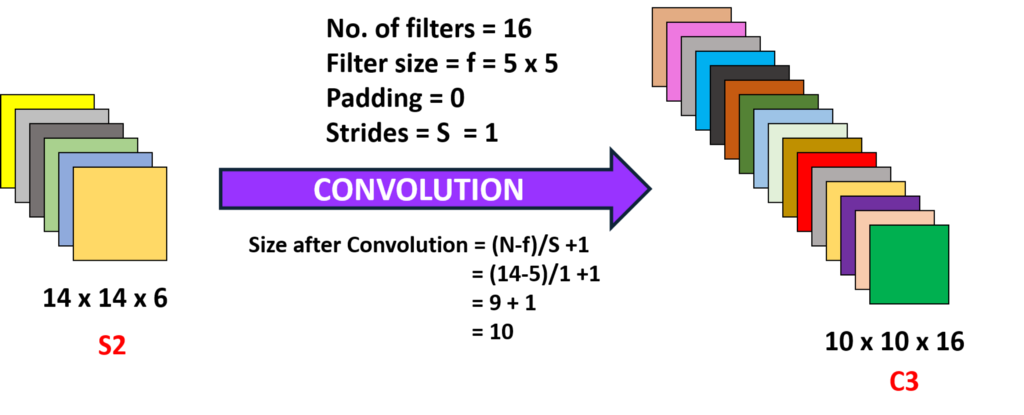

회선 2(3 층):

여기서 우리는 14x14x6i.e 이전 o/p,convoluting 필터의 크기가 5×5,으로 보폭은 1 나.,e(없음 건너뛰기),그리고 제로 패딩 그래서 우리는 10×10 출력을 지금 여기서 우리는 16 같은 필터 깊이의 6convoluting 따라서 획득된 출력의 10x10x16

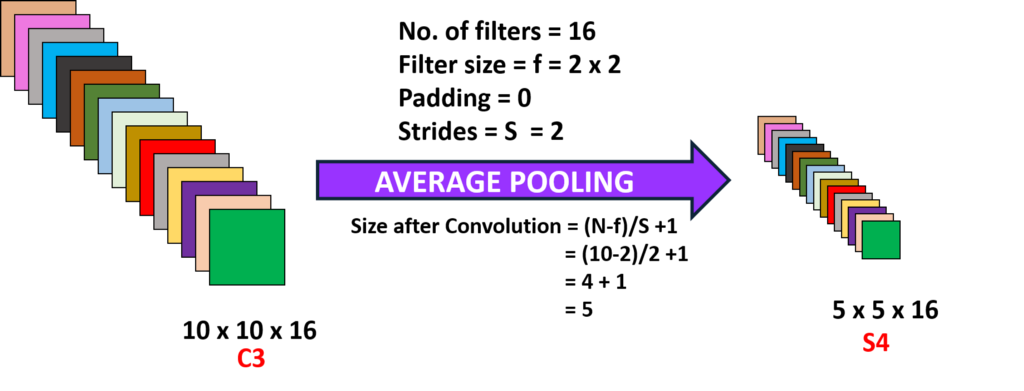

Pooling2(4 층):

여기서 우리는 출력 이전 층 수행 평균 풀링으로 보폭 2 나.,yer(N-1):

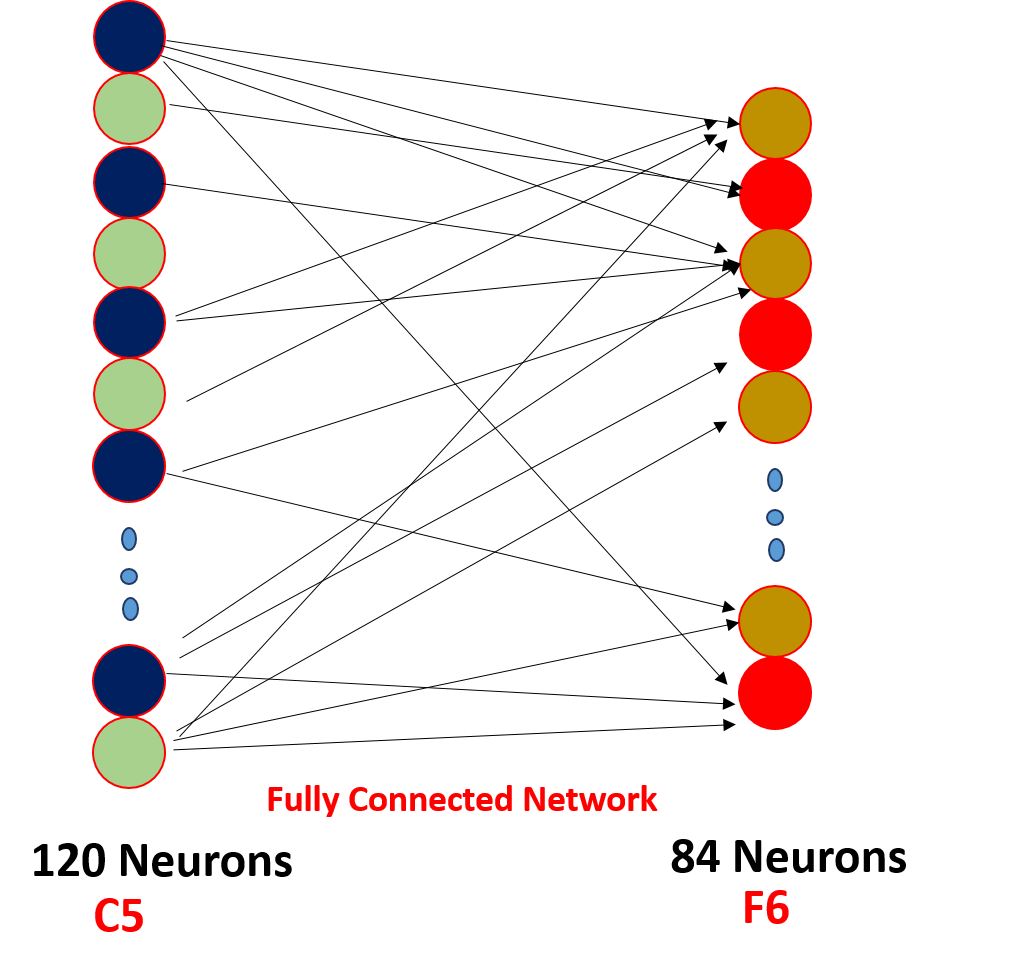

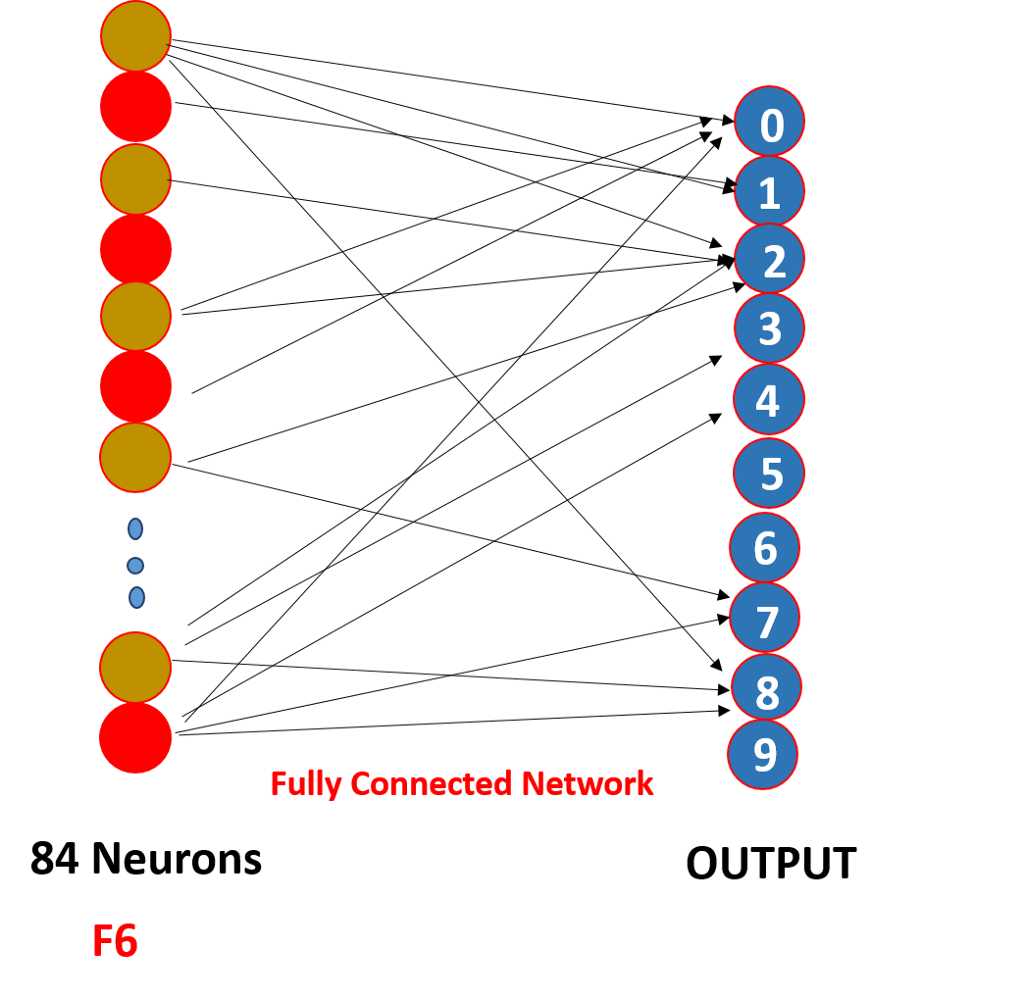

마지막으로, 우리는 모든 평평하게 5x5x16 단일 레이어의 크기는 400 는 값을 입력하 feed-forward neural 네트워크의 120 신경 데 중량 크기의 행렬하고 숨겨진 계층의 84 개의 신경 세포 연결하여 120 개의 신경 세포와 무게의 행렬 및 이 84 신경 실제로 연결되어 있는 10 출력 신경

이 o/p 신경을 마무리 예측번호에 의해 softmaxing.,

Convolutional Neural Network 는 실제로 어떻게 작동합니까?,

이 작품을 통해 체중 공유고 부족한 연결을,

.png)

여기에 당신이 볼 수 있듯이 회선에는 어떤 무게 이러한 무게는 공유하여 모든 입력 신경지,각각의 입력이 있는 별도의 체중이라고 체중 공유 과하지 않는 모든 입력 신경 세포가 연결되는 출력 신경 a’o 만 일부는 복잡한 해고로 알려진 sparse 연결,CNN 다르지 않 feed-forward neural networks 이러한 두 가지 특성들을 특별하다!!!,

는

1 을 보는 것을 가리 킵니다. 후에는 모든 회선을 출력 전송을 활성화 기능을 얻을 수 있도록 더 나은 기능을 유지하는 양성 예를 들어:ReLu

2. 스파 스 연결성과 체중 공유는 convolutional neural network 가

3 작동하는 주된 이유입니다. 개념의 번호를 선택하의 필터를 사이에서 레이어와 패딩의 보폭 및 여과 차원에서 촬영 하고 있 숫자의 실험,그것에 대해 걱정하지 마십시오,건설에 초점 재단은,언젠가는 당신은 할 것이 실험과 더 생산적인 중 하나!!!,

읽을 수도 있습니다 이 문서에서 우리의 모바일 앱