ce este arhitectura rețelei neuronale convoluționale?

Acest articol a fost publicat ca parte a Blogathon Data Science.

Introducere

lucrați la un proiect privind recunoașterea imaginii sau detectarea obiectelor, dar nu aveți elementele de bază pentru a construi o arhitectură?,în acest articol, vom vedea care sunt arhitecturile de rețele neuronale convoluționale chiar de la bază și vom lua o arhitectură de bază ca studiu de caz pentru a aplica cunoștințele noastre, singura condiție prealabilă este că trebuie doar să știți cum funcționează convoluția, dar nu vă faceți griji că este foarte simplu !!

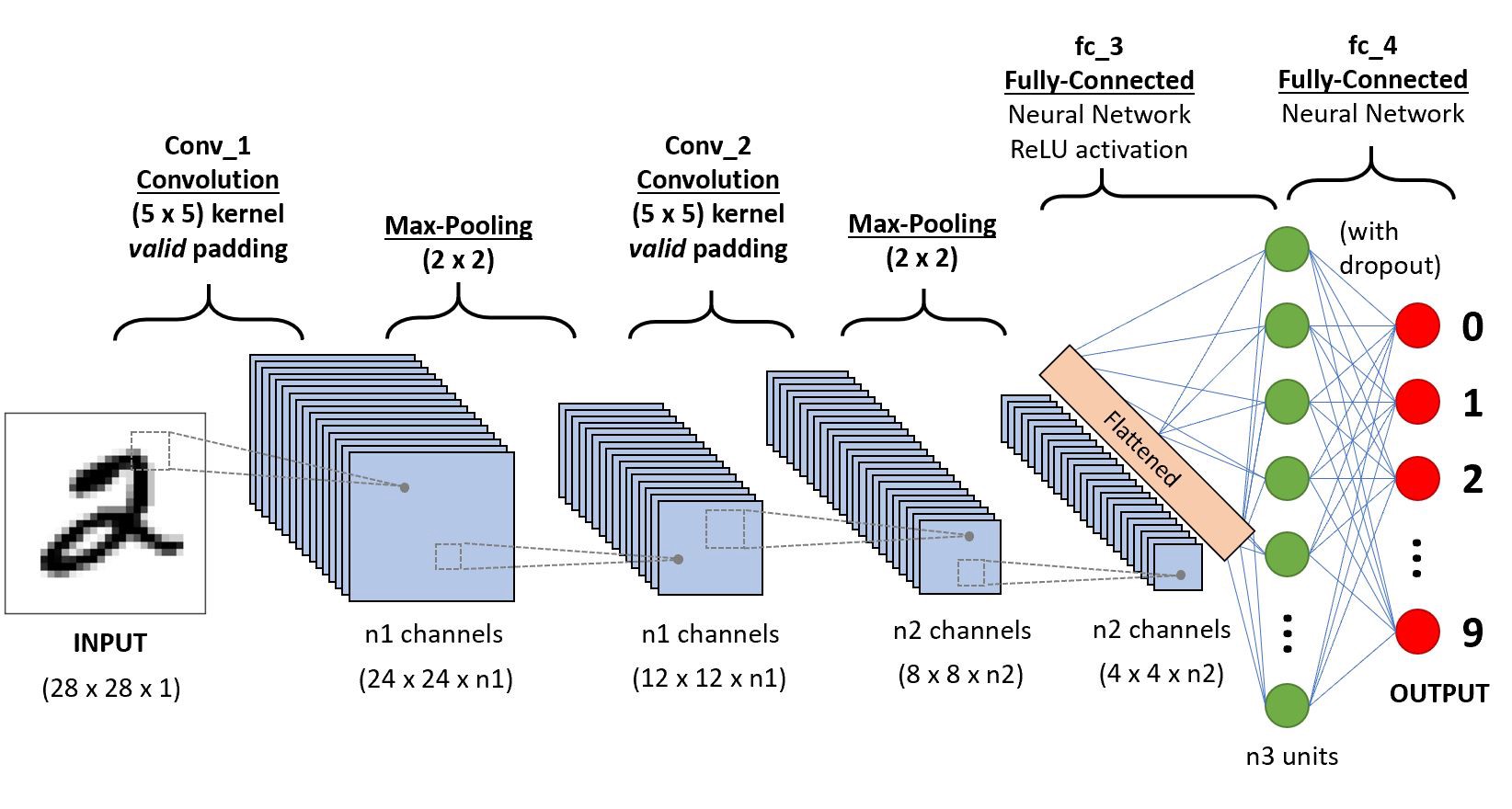

Să luăm un simplu Convoluțional rețea neuronală,

Vom merge strat de înțelept pentru a obține perspective profunde despre această CNN.,

în Primul rând, există câteva lucruri de învățat de la stratul 1, care este striding și umplutură, vom vedea fiecare dintre ele în scurtă cu exemple

Să presupunem acest lucru în intrare matrice de 5×5 și un filtru de matrice 3X3, pentru cei care nu stiu ce filtru este un set de greutăți într-o matrice aplicat pe o imagine sau o matrice pentru a obține caracteristicile necesare, vă rugăm să căutare pe convoluție dacă aceasta este prima dată!notă: luăm întotdeauna suma sau media tuturor valorilor în timp ce facem o convoluție.,

un filtru poate fi de orice adâncime, dacă un filtru are o adâncime d poate merge la o adâncime de straturi d și convolute i.,”f4a6da248a”>

Aici intrarea este de dimensiune 5×5 după aplicarea de 3×3 kernel sau filtre obține un 3×3 de ieșire caracteristică hartă, astfel încât să încercăm să formuleze această

.png)

Astfel încât producția înălțime este formulat și același lucru cu o/p lățime de asemenea…

Padding

în Timp ce aplicarea convolutions nu vom obține la ieșire dimensiuni la fel ca intrare vom pierde date peste granițe astfel încât să putem adăuga un chenar de zerouri și recalculeze convoluție acoperă toate valorile de intrare.,r lățime, de asemenea,

Striding

Unii ori nu vrem să captura toate datele sau informațiile disponibile, astfel încât să sărim peste niște celule vecine lasă-ne să-l vizualizezi,

Aici de intrare matrice sau imaginea este de dimensiuni 5×5 cu un filtru de 3×3 și un pas de 2 astfel încât de fiecare dată când sărim peste două coloane și răsucit, hai sa ne facem asta

.png)

în Cazul în care dimensiunile sunt în plutesc puteți lua ceil() pe ieșirea eu.,e (Next Close integer)

aici H se referă la înălțime, deci înălțimea de ieșire este formulată și aceeași cu lățimea o/p și aici 2 este valoarea pasului, astfel încât să o puteți face ca S în formule.

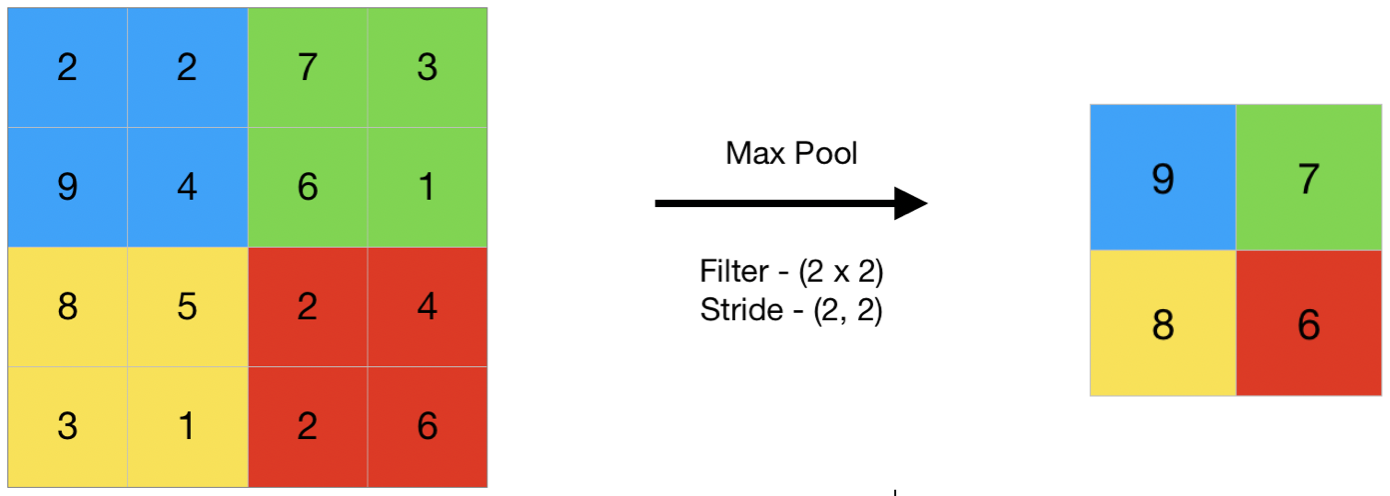

punerea în Comun

În termeni generali comun se referă la o porțiune mică, așa că aici vom lua o mică porțiune de intrare și să încerce să ia valoarea medie menționată ca mediu comun sau de a lua o valoare maximă numit ca max comun, deci de a face punerea în comun pe o imagine nu luăm toate valorile facem un rezumat valoare peste toate valorile prezente !!!,

aici este un exemplu de max comun deci, aici luând un pas de doi vom lua valoarea maximă prezente în matricea

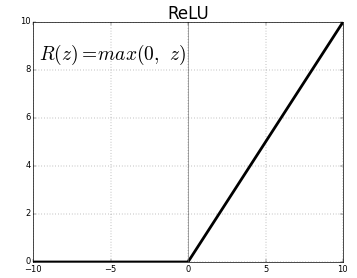

Activare funcție

Funcția de activare este un nod care este pus la sfârșitul sau în între Rețele Neuronale. Ele ajută să decidă dacă neuronul ar trage sau nu., Avem diferite tipuri de funcții de activare doar ca în figura de mai sus, dar pentru acest post, mi se va concentra asupra Rectificat Liniar Unitate (ReLU)

nu fixați fălcile tale, acest lucru nu este atât de complex această funcție pur și simplu se întoarce 0 dacă valoarea este negativă, altfel se revine la aceeași valoare ai dat, nimic, dar elimină negative ieșiri și menține valori între 0 la +infinit

Acum, că am învățat toate elementele de bază necesare să ne studieze o bază neuronală numită LeNet.,

LeNet-5

înainte de a începe vom vedea care sunt arhitecturile proiectate până în prezent.,ures

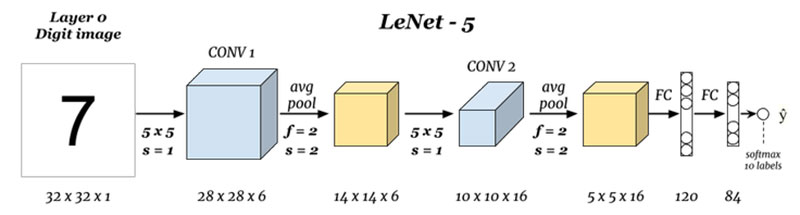

care sunt intrări și ieșiri (Layer 0 și Stratul N) :

Aici suntem estimarea cifre bazat pe imaginea de intrare dat, rețineți că aici imaginea este de dimensiuni inaltime = 32 pixeli, width = 32 pixeli, și o adâncime de 1, deci putem presupune că aceasta este o imagine în tonuri de gri sau alb-negru, păstrând în minte rezultatul este un softmax de toate cele 10 valori, aici softmax oferă probabilități sau rapoarte pentru toate cele 10 cifre, putem lua ca număr de ieșire cu cea mai mare probabilitate sau raport.,ef5″>

Aici suntem luați de intrare și răsucirea cu filtre de dimensiune 5 x 5 producând astfel o ieșire de dimensiune 28 x 28 verifica formula de mai sus pentru a calcula ieșire dimensiuni, lucru de aici este am luat 6 astfel de filtre și, prin urmare, adâncimea de conv1 este de 6, prin urmare, dimensiunile sale au fost, 28 x 28 x 6 acum trece asta la comun strat

Gruparea 1 (Stratul 2) :

.png)

Aici suntem luați 28 x 28 x 6 ca intrare și aplicarea mediu comun de o matrice 2×2 și un pas de 2 m.,e situându-se un 2 x 2 matricea de intrare și de a lua mediu de toți cei patru pixeli și sărituri, cu un salt de 2 coloane de fiecare dată, astfel, oferindu-14 x 14 x 6 ca ieșire suntem calcul comun pentru fiecare strat deci, aici, la adâncimea de ieșire este de 6

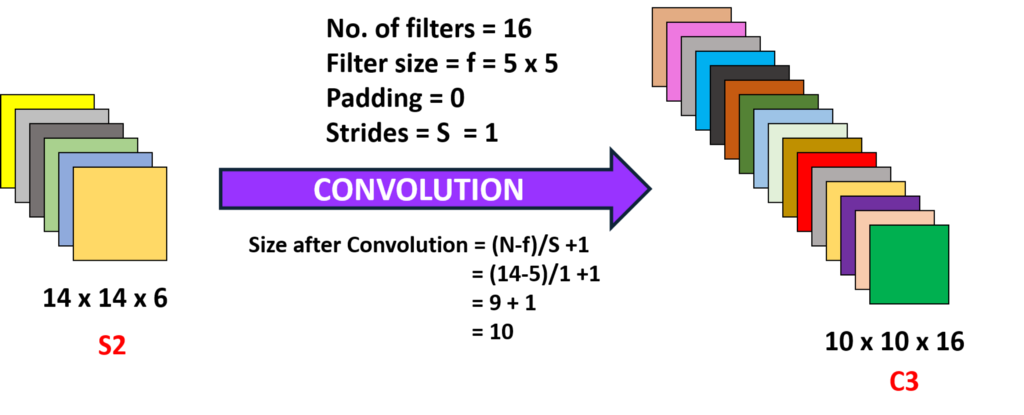

Convoluție 2 (Layer 3) :

Aici suntem luați de la 14 x 14 x 6 m.e anterior o/p și răsucirea cu un filtru de dimensiune 5 x5, cu un pas de 1 m.,e (nu săriți), și cu zero garniture așa că am obține 10 x 10 ieșire, acum suntem aici, luând 16 astfel de filtre de profunzime 6 și răsucirea obținându-se astfel o putere de 10 x 10 x 16

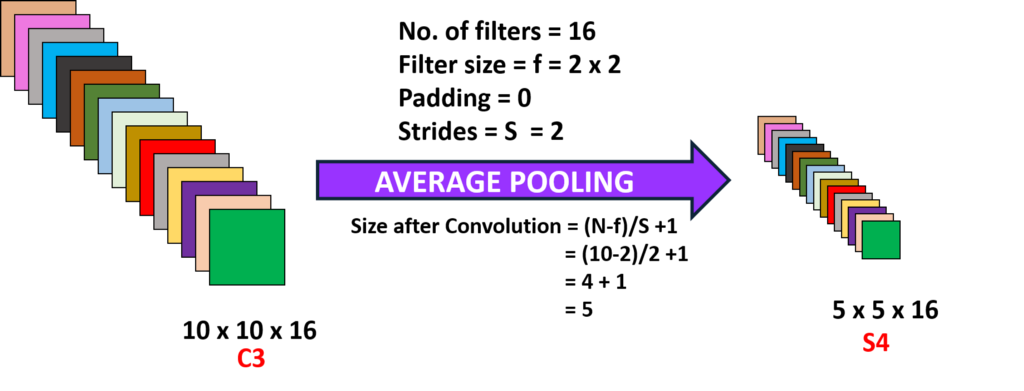

Gruparea 2 (Layer 4):

Aici suntem luați de ieșire din stratul anterior și efectuarea mediu comun cu un pas de 2 m.,yer (N-1) :

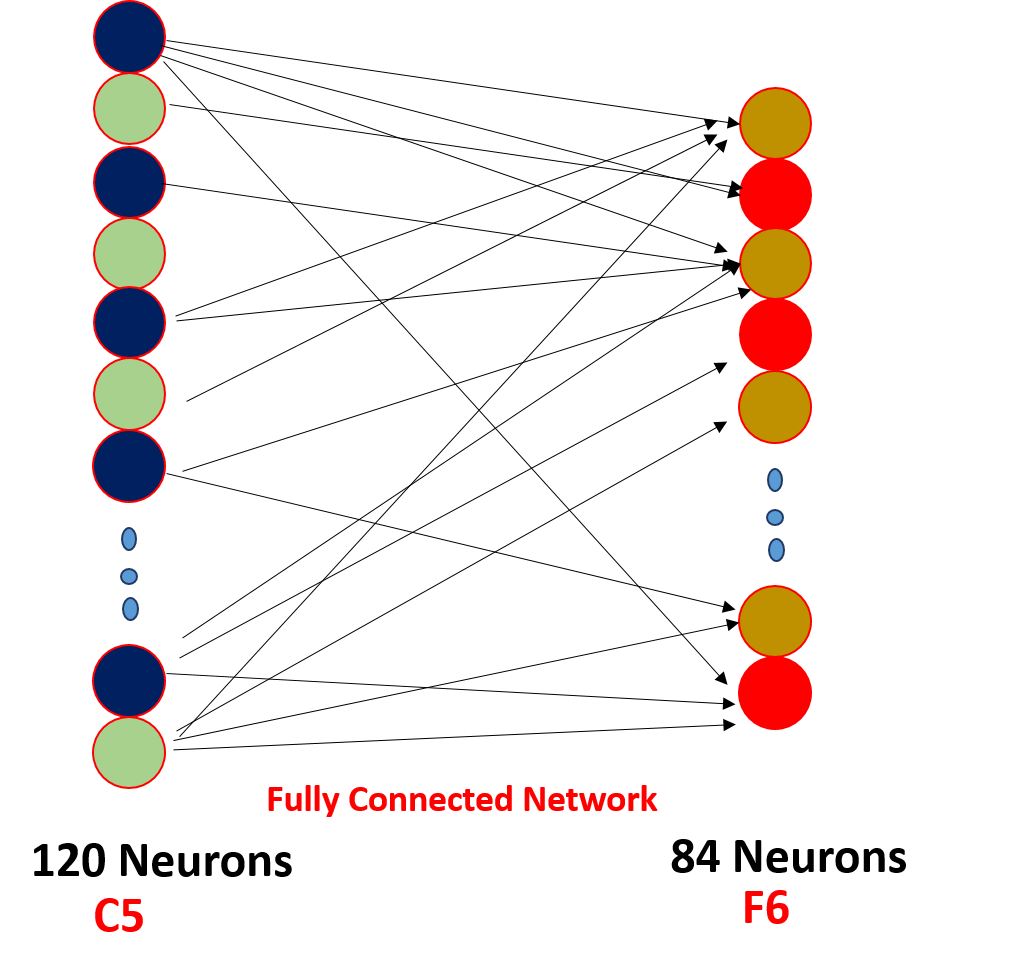

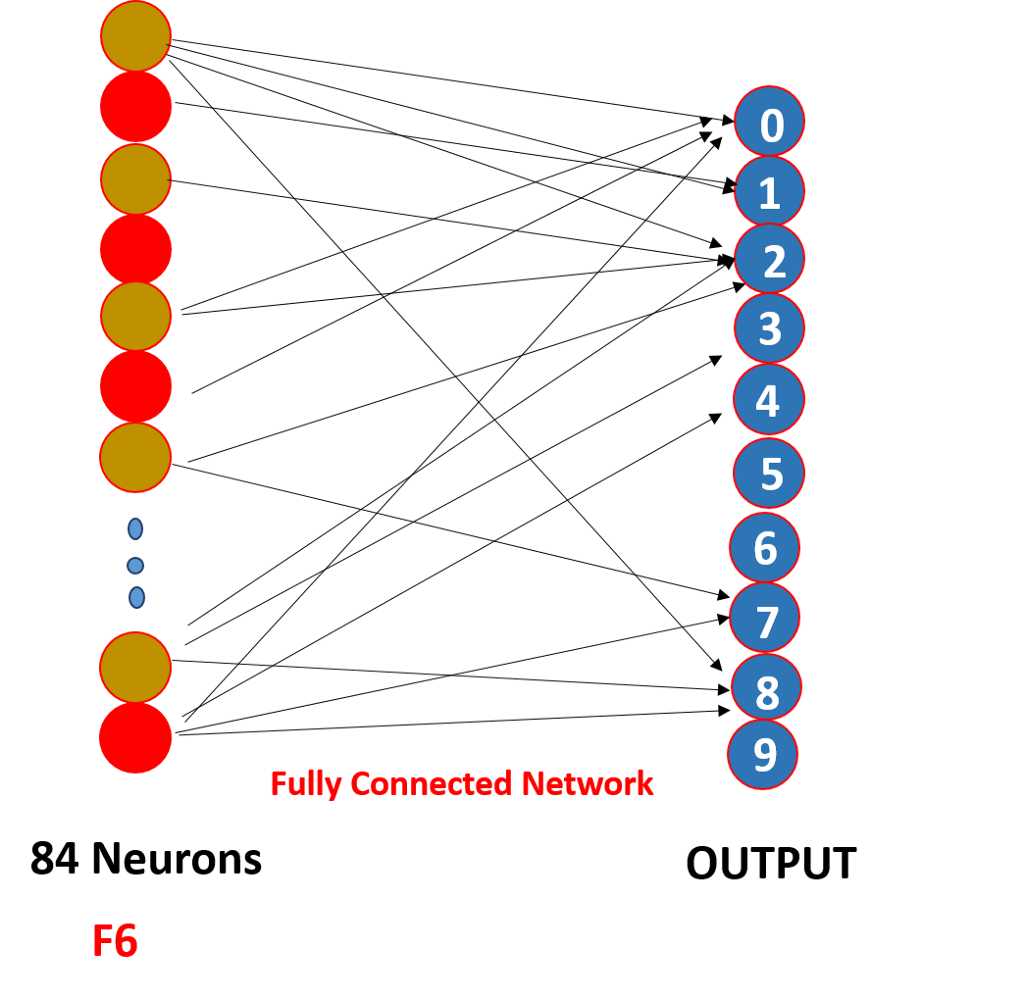

în cele din Urmă, am aplatiza toate 5 x 5 x 16 de la un singur strat de dimensiunea 400 de valori o introducerea ei la un feed-forward rețea neuronală de 120 de neuroni cu o greutate matrice de dimensiune și un strat ascuns de 84 de neuroni legate de 120 de neuroni cu o greutate matrice și aceste 84 de neuroni într-adevăr sunt conectate la un 10 de ieșire neuroni

Aceste o/p neuroni finaliza numărul prezis de softmaxing .,

cum funcționează de fapt o rețea neuronală convoluțională?,

Acesta funcționează prin schimbul de greutate și rare de conectivitate,

.png)

Deci, aici puteți vedea convoluție are unele greutăți aceste greutăți sunt împărtășite de toți intrare neuroni, nu fiecare intrare separate, are o greutate sunat greutate de partajare, și nu toate de intrare neuroni sunt conectate la ieșire un neuron ‘ o doar unele care sunt complicate sunt concediat cunoscut sub numele de rare conectivitate, CNN este diferit de feed-forward rețele neuronale aceste două proprietăți le face speciale !!!,

puncte să se uite la

1. După fiecare convoluție, ieșirea este trimisă către o funcție de activare, astfel încât să se obțină caracteristici mai bune și să se mențină pozitivitatea, de exemplu: ReLu

2. Conectivitatea redusă și partajarea greutății sunt principalul motiv pentru care o rețea neuronală convoluțională funcționează

3. Conceptul de a alege un număr de filtre între straturi și umplutură și dimensiunile pasului și filtrului sunt luate în a face o serie de experimentări, nu vă faceți griji despre asta, concentrați-vă pe fundația clădirii, într-o zi veți face acele experimente și veți construi unul mai productiv!!!,

puteți citi acest articol și pe aplicația noastră mobilă